Les experts en sécurité tirent la sonnette d'alarme contre les escroqueries vocales basées sur l'IA, alors que ces types d'arnaques atteignent des sommets inégalés, selon un nouveau rapport de McAfee

Le monde de l'IA est aussi bon que mauvais et un nouveau rapport d'experts en sécurité tire la sonnette d'alarme contre les escroqueries vocales basées sur la technologie de l'IA.

Ce type d'escroquerie semble très répandu et très convaincant pour certaines personnes, car on a l'impression de parler à un être cher. Mais en réalité, c'est loin d'être le cas. Le rapport approfondi, qui explique comment fonctionne l'ensemble du processus de clonage, a laissé beaucoup de gens dans l'expectative. De même, il explique comment les escroqueries de ce type sont devenues si courantes qu'il est beaucoup plus facile d'y tomber aujourd'hui qu'auparavant.

Elle fait également la lumière sur les coûts moyens qui y sont liés et sur la manière dont on peut s'en prémunir et se tenir à l'écart de toutes les escroqueries vocales construites à l'aide de la technologie de l'IA.

Le mois dernier, nous avons été témoins d'escroqueries à l'IA choquantes mais si bien conçues que beaucoup les ont jugées effrayantes. L'une d'entre elles était liée à l'usurpation d'identité : des proches apparaissaient sur l'appareil de la victime comme étant à l'origine de l'appel. Une autre utilisait un clone vocal d'IA pour extorquer à la mère des fonds au hasard afin de libérer sa fille, qui n'avait pas été kidnappée.

Les experts estiment donc qu'il ne faut pas attendre longtemps avant de voir les attaquants combiner l'usurpation d'identité et les clones utilisant la technologie de l'IA. C'est dans ce contexte que le rapport McAfee est apparu.

Il présente des escroqueries vocales basées sur l'IA qui sont conçues pour faire prendre conscience d'une menace avec plusieurs méthodes permettant à la fois de l'empêcher de se produire et de fournir la protection nécessaire. Mais comment fonctionne le monde du clonage de la voix artificielle ?

Selon McAfee, les escroqueries vocales sont une combinaison d'escroqueries à l'imposteur qui existent depuis longtemps. Les escrocs utilisent la voix d'une personne pour lui demander des fonds en cas d'urgence ou pour faire croire qu'ils détiennent quelqu'un pour obtenir une rançon.

Les outils de clonage de voix basés sur l'IA sont peu coûteux et facilement disponibles. C'est non seulement très rapide, mais aussi très simple, car de nombreuses personnes malveillantes utilisent désormais des clones de voix. Il leur suffit d'obtenir des échantillons audio pour y parvenir, car les gens partagent leurs voix sur diverses applications de médias sociaux. Et plus il y a de partages en ligne, plus il est facile pour les acteurs de rechercher une voix et de la cloner.

Comme on peut s'y attendre, le clonage de voix peut sembler être quelque chose de nouveau et nous avons été témoins de quelques histoires énormes dans le monde réel concernant de telles escroqueries. Mais en réalité, l'étude de McAfee a montré qu'elles deviennent de plus en plus courantes avec le temps.

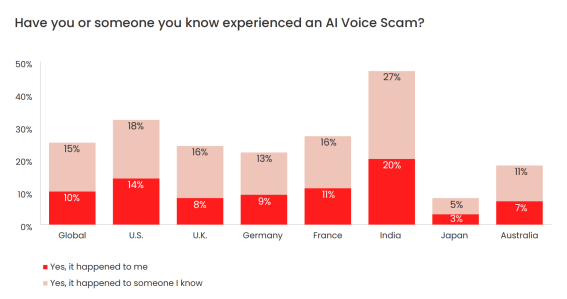

En moyenne, environ 25 % de la population mondiale qui a participé à l'enquête affirme avoir été victime d'une escroquerie liée au monde de l'IA vocale ou avoir connu des personnes qui avaient été touchées par ce type d'escroquerie.

Des pays comme l'Inde ont été particulièrement frappés, puisque 47 % des personnes interrogées dans le cadre de l'étude affirment connaître quelqu'un qui a été victime de ce type d'escroquerie.

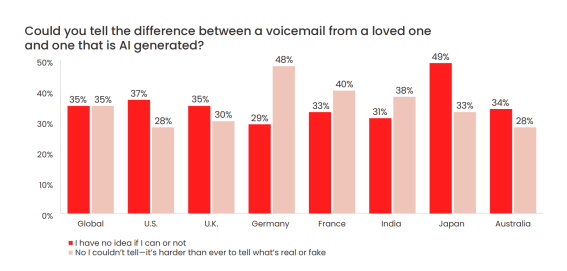

En ce qui concerne la précision, vous serez surpris de constater qu'elle est de 95 %, car de nombreux cas ont été signalés par le public, qui a révélé que ces voix donnaient l'impression que la personne avait été clonée. Dans un cas précis, un cybercriminel demandait de l'argent pour un enlèvement qui n'avait jamais eu lieu. Il est donc évident qu'il est aujourd'hui plus difficile que jamais de distinguer les vraies des fausses personnes.

Malheureusement, 77 % des personnes interrogées affirment avoir perdu de l'argent dans ce type d'escroquerie et les chiffres varient entre 1 000 et 15 000 dollars. Au total, ces escroqueries à l'imposture ont permis un vol d'une valeur de 2,6 milliards de dollars.

Source : Rapport de McAfee (PDF)

Et vous ?

Quel est votre avis sur le sujet ?

Trouvez-vous que les conclusions de ce rapport de McAfee sont pertinentes ?

Avez-vous déjà été victime, ou témoin, d'une escroquerie à la voix artificielle et, si oui, comment avez-vous réagi ?

Selon vous, quelles mesures peuvent être mises en place pour se protéger contre les escroqueries vocales basées sur l'IA ? Et quels rôles les entreprises technologiques devraient-elles jouer dans la prévention de ces pratiques malveillantes ?

Pensez-vous qu'un changement d'attitude de la société à l'égard du partage d'informations personnelles en ligne peut contribuer à diminuer ces types d'escroqueries ?

Voir aussi

Arnaque à l'IA : un couple canadien perd 21 000 dollars à cause d'une fausse voix générée par l'IA qui avait imité à la perfection la voix de leur fils

Des milliers de personnes arnaquées par des voix d'IA imitant des proches en cas d'urgence, 11 millions de dollars ont été volés par le biais de ces escroqueries par téléphone en 2022

Des cybercriminels ont réussi à escroquer 222 000 € en utilisant un logiciel boosté à l'IA pour reproduire la voix d'un PDG

Les nouveaux outils de clonage de voix par l'IA ajoutent "de l'huile sur le feu" de la désinformation, une voix de Joe Biden générée par l'IA prononce un discours "hilarant" sur l'état de l'Union

Répondre avec citation

Répondre avec citation

Partager