Inflection AI développe un superordinateur équipé de 22 000 GPU NVIDIA H100 AI

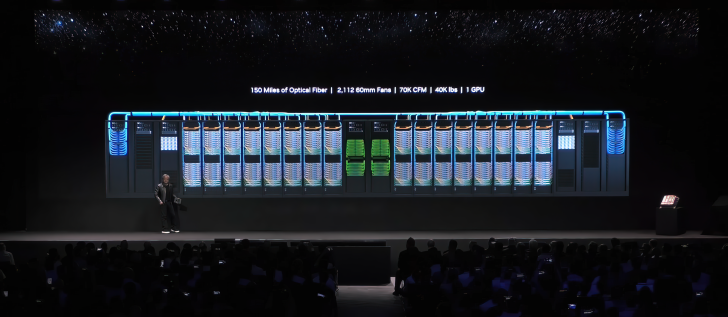

Inflection a annoncé la construction d'un des plus puissant superordinateurs au monde basé sur l'IA, et il semble que nous ayons enfin un aperçu de ce qu'il serait. Le superordinateur d'Inflection serait équipé de 22 000 GPU H100 et, d'après les analyses, il contiendrait près de 700 racks à quatre nœuds de CPU Intel Xeon. Le superordinateur consommera une puissance stupéfiante de 31 mégawatts.

Inflection AI, une startup spécialisée dans l'IA, a construit un superordinateur de pointe équipé de 22 000 GPU NVIDIA H100, un nombre phénoménal qui lui confère d'énormes performances de calcul.

Le superordinateur d'Inflection AI devrait être l'un des plus puissant de l'industrie, juste derrière le Frontier d'AMD.

Pour ceux qui ne connaissent pas Inflection AI, il s'agit d'une entreprise dont l'objectif est de créer une "IA personnelle pour tous". L'entreprise est largement connue pour son modèle d'IA Inflection-1 récemment introduit, qui alimente le chatbot Pi. Bien que le modèle d'IA n'ait pas encore atteint le niveau de ChatGPT ou des modèles LaMDA de Google, des rapports suggèrent qu'Inflection-1 est performant dans les tâches de "bon sens", ce qui le rend beaucoup plus adapté à des applications telles que l'assistance personnelle.

Le fait surprenant concernant le superordinateur est l'acquisition de 22 000 GPU NVIDIA H100. Nous savons tous que, ces derniers temps, il a été difficile d'acquérir ne serait-ce qu'une seule unité de H100, car elles sont très demandées et NVIDIA ne peut pas faire face à l'afflux de commandes. Dans le cas d'Inflection AI, NVIDIA envisage d'être un investisseur dans la société, c'est pourquoi dans leur cas, il est plus facile de mettre la main sur un nombre aussi important de GPU.

Inflection AI a levé environ 1,5 milliard de dollars d'investissements et la société est actuellement évaluée à 4 milliards de dollars. Grâce à ce superordinateur, le modèle d'IA "Inflection 1" devrait s'améliorer considérablement, en particulier dans les tâches de codage, car l'entreprise a du retard dans ce domaine.

Source : HardwareLuxx

Et vous ?

Que pensez-vous de cette annonce ?

Que pensez-vous de cette volonté de créer une IA plus personnelle ?

Voir aussi :

Google sera très différent en 2033, la recherche classique en ligne sera remplacée par la conversation

Selon Mustafa Suleymant, cofondateur de DeepMind

Une étude affirme qu'une poignée d'individus et d'entreprises privées contrôlent désormais la recherche en IA,

Les auteurs mettent en garde contre les conséquences négatives de cette domination

Les nouvelles GPU NVIDIA pour l'intelligence artificielle seraient jusqu'à 4,5 fois plus rapides que les précédentes

Selon NVIDIA

Répondre avec citation

Répondre avec citation

Partager