Une étude révèle que les gens n'aiment pas recevoir des réponses générées par un système d'IA lors d'une conversation

l'utilisateur d'un tel outil est perçu comme moins coopératif et moins sincère

Des expériences menées par des chercheurs de l'université américaine Cornell, à Ithaca dans l’État de New York, révèlent que les gens n'apprécient pas vraiment lorsqu'ils se rendent compte que c'est une machine qui leur répond alors qu'ils s'attendaient à des réponses sincères de la part d'un humain. En fait, les chercheurs ont étudié les conséquences sociales de l'une des applications les plus répandues de l'IA, les suggestions de réponses algorithmiques (appelées réponses intelligentes), qui sont utilisées pour envoyer des milliards de messages chaque jour. L'étude montre que les gens ont moins d'estime pour les personnes qui utilisent de tels outils.

De nombreuses études se sont intéressées aux impacts de l'IA sur le marché de l'emploi, mais très peu ont porté sur les risques pour la société. C'est d'ailleurs pour cela qu'Elon Musk et certains de ses pairs ont demandé un moratoire de six afin de faire la lumière sur les dangers de l'IA pour l'humanité. En outre, les critiques des outils d'IA tels que ChatGPT se sont concentrés sur les préjudices que ses résultats peuvent causer, comme la désinformation et les contenus haineux, racistes, etc. Mais le simple choix d'un style de conversation sociale et la tentative de l'IA d'imiter l'homme le plus fidèlement possible comportent également des risques.

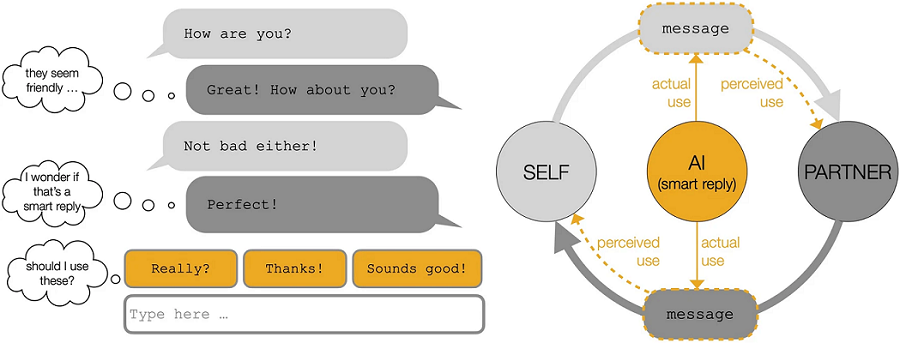

Les chercheurs de l'université américaine Cornell ont étudié les conséquences sociales de l'une des applications les plus répandues de l'IA, les suggestions de réponses algorithmiques (ou réponses intelligentes), qui sont utilisées pour envoyer des milliards de messages chaque jour. Ils ont rapporté les conclusions de leur étude dans un article publié la semaine dernière dans la revue scientifique Scientific Reports. Les conclusions de l'étude sont pour le moins intéressantes. Voici comment s'est déroulée l'étude : l'équipe de chercheurs a recruté des participants et les a répartis en 219 paires. Ces sujets ont ensuite été invités à discuter de questions politiques par SMS.

Pour certaines paires, les deux participants de chaque paire ont été invités à n'utiliser que les suggestions de Smart Reply de Google, qui suit un sujet de conversation et recommande des choses à dire. D'autres paires ont été invitées à ne pas utiliser du tout l'outil, et pour d'autres paires, un participant de chaque paire a été invité à utiliser Smart Reply. Un message sur sept a donc été envoyé à l'aide d'un texte généré automatiquement lors de l'expérience, ce qui, selon les chercheurs, a rendu les conversations apparemment plus efficaces et sur un ton positif. En outre, les réponses intelligentes permettent également parfois d'accélérer la conversation.

Cela dit, lorsqu'un participant soupçonne que son interlocuteur lui répondait avec des réponses passe-partout, il pensait qu'il était moins coopératif et se sentait moins à l'aise avec lui. « Nous constatons que l'utilisation de réponses algorithmiques modifie le langage et les relations sociales. Elle augmente la vitesse de communication, l'utilisation d'un langage émotionnel positif et les interlocuteurs se sentent mutuellement plus proches et plus coopératifs. Conformément aux hypothèses courantes sur les effets négatifs de l'IA, les personnes sont évaluées plus négativement si elles sont soupçonnées d'utiliser des réponses algorithmiques », a écrit l'équipe.

« Par conséquent, même si l'IA peut accélérer la communication et améliorer les perceptions interpersonnelles, les connotations antisociales qui prévalent à l'égard de l'IA compromettent ces avantages potentiels si elle est utilisée ouvertement », explique l'équipe. Malte Jung, coauteur de l'étude et professeur agrégé en sciences de l'information à Cornell, explique que ce constat pourrait être dû au fait que les gens ont tendance à faire moins confiance à la technologie qu'à d'autres humains, ou qu'ils perçoivent son utilisation dans les conversations comme inauthentique (l'utilisateur est vu comme moins coopératif, moins attentionné ou moins sincère).

« L'une des explications est que les gens pourraient projeter leur opinion négative de l'IA sur la personne qu'ils soupçonnent de l'utiliser. Une autre explication pourrait être que le fait de soupçonner quelqu'un d'utiliser l'IA pour générer ses réponses pourrait conduire à percevoir cette personne comme moins attentionnée, moins sincère ou moins authentique. Par exemple, un poème d'un amoureux sera probablement reçu moins chaleureusement s'il a été généré par ChatGPT », a déclaré Jung. Par exemple, des doyens d'université ont été suspendus après avoir utilisé ChatGPT pour envoyer des courriels à des étudiants à la suite d'une fusillade de masse.

Le message a suscité un tollé, de nombreuses personnes ayant pointé du doigt "le manque de sérieux et de compassion des auteurs du courriel". Un critique a déclaré : « il y a une ironie malsaine et tordue à demander à un ordinateur d'écrire votre message sur la communauté et la solidarité parce que vous ne pouvez pas prendre la peine d'y réfléchir vous-même. Les administrateurs ne se soucient que de la perception et de leur politique institutionnelle visant à sauver la face. Les proviseurs, les doyens et le chancelier, faites-en plus. Et conduisez-nous vers un avenir meilleur avec une empathie authentique et humaine, pas avec un robot ».

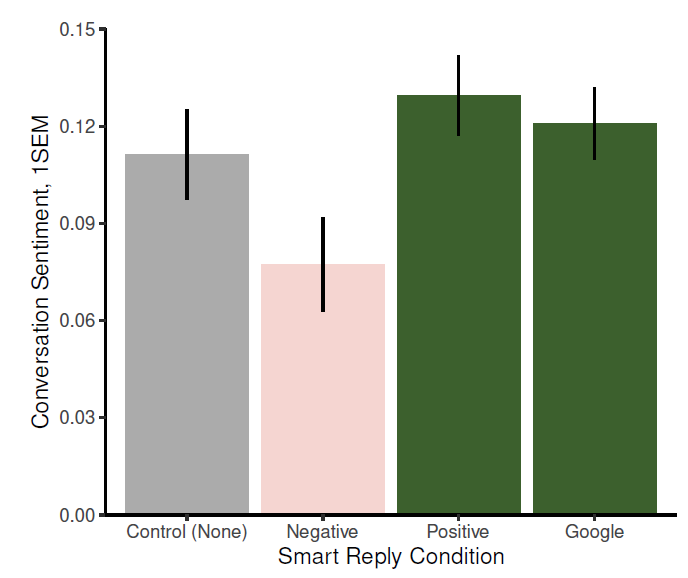

Les chercheurs de Cornell ont mené une seconde expérience, le sujet de conversation étant toujours la politique. Cette fois, cependant, ils ont été répartis en groupes qui devaient taper manuellement leurs propres réponses, ou qui pouvaient utiliser la réponse intelligente par défaut de Google, ou encore qui avaient accès à un outil générant un texte avec un ton positif ou négatif. Les discussions menées à l'aide de la réponse intelligente de Google ou de l'outil générant un texte positif ont été perçues comme plus optimistes que celles où l'on n'utilisait pas d'outils d'IA ou où l'on répondait avec des réponses négatives générées automatiquement.

Les chercheurs estiment que cela montre qu'il y a des avantages à communiquer en utilisant l'IA dans certaines situations, telles que les scénarios plus transactionnels ou professionnels. « Nous avons demandé aux participants de discuter des politiques relatives au rejet injuste du travail. Dans un tel contexte lié au travail, un ton positif plus amical a principalement des conséquences positives, car un langage positif rapproche les gens les uns des autres. Mais dans un autre contexte, le même langage peut avoir un impact différent, voire négatif », explique Jung. Une personne qui annonce un décès n'appréciera peut-être pas une réponse joyeuse.

« En d'autres termes, la signification des termes "positif" et "négatif" varie considérablement en fonction du contexte », a déclaré Jung. Selon l'équipe de chercheurs, la communication humaine va être façonnée par l'IA à mesure que la technologie devient de plus en plus accessible. Microsoft et Google, par exemple, ont tous deux annoncé des outils destinés à aider les utilisateurs à rédiger automatiquement des courriels ou des documents. « L'IA peut vous aider à écrire, mais elle modifie votre langage d'une manière inattendue, notamment en vous faisant paraître plus positif », note Jess Hohenstein, auteur principal de l'étude et chercheur postdoctoral.

« Cela suggère qu'en utilisant l'IA génératrice de texte, vous sacrifiez une partie de votre voix personnelle », a-t-elle ajouté. Hohenstein a déclaré qu'elle aimerait voir plus de transparence autour de ces outils, y compris un moyen de divulguer quand les gens les utilisent. Selon elle, prendre des mesures pour plus d'ouverture et de transparence autour des grands modèles de langage pourrait potentiellement aider à atténuer la méfiance générale que l'équipe a constatée à l'égard de l'IA.

Sources : rapport de l'étude, billet de blogue

Et vous ?

Quel est votre avis sur le sujet ?

Voir aussi

Des doyens d'université suspendus après avoir utilisé ChatGPT pour envoyer des courriels à des étudiants sur une fusillade de masse, le message a suscité un tollé au sein de l'établissement

GPT-4 produirait des informations erronées, beaucoup plus que GPT-3.5, selon une étude de NewsGuard, OpenAI avait pourtant déclaré le contraire

Télétravail : 60 % des salariés français préféreraient parler de leurs problèmes de stress et d'anxiété à un robot plutôt qu'à leur manager, selon un rapport d'Oracle

Microsoft prétend que GPT-4 montre des « étincelles » d'intelligence artificielle générale : « nous pensons que l'intelligence de GPT-4 signale un véritable changement de paradigme »

Répondre avec citation

Répondre avec citation

Partager