L'IA pourrait conduire à une vague massive de production de logiciels ultra-bon marché,

en minimisant considérablement le besoin d'ingénieurs logiciels humains hautement rémunérés

Pour Paul Kedrosky et Eric Norlin de SK Ventures, il y a une immense hyperbole sur les développements récents de l'intelligence artificielle, en particulier les grands modèles de langage comme ChatGPT. Et l'impact matériel de ces technologies sur les emplois suscite également des inquiétudes justifiées. Cependant, selon eux, les observateurs manquent deux choses très importantes :

- chaque vague d'innovation technologique a été déclenchée par quelque chose de coûteux devenu suffisamment bon marché pour être gaspillé ;

- la production de logiciels a été trop complexe et coûteuse pendant trop longtemps, ce qui nous a amenés à sous-produire des logiciels pendant des décennies, ce qui a entraîné une immense dette technique à l'échelle de la société.

Cette dette technique est sur le point de se contracter de manière dramatique à l'échelle de l'économie alors que le coût et la complexité de la production de logiciels s'effondrent, libérant une vague d'innovation.

Dans la foulée de la sortie publique de GPT-4, une équipe de scientifiques de Microsoft AI a publié un document de recherche affirmant que le modèle de langage OpenAI dui alimente Bing AI montre des « étincelles » d'intelligence artificielle générale.

L’intelligence artificielle générale (IAG) désigne des systèmes capables de donner de « bons » résultats dans toutes les tâches cognitives propres aux êtres humains ou aux animaux dits supérieurs.

Au vu de cette définition, on comprend aisément pourquoi l'accent est mis sur les « étincelles ». Les chercheurs prennent soin dans l'article de caractériser les prouesses du GPT-4 comme « seulement un premier pas vers une série de systèmes de plus en plus intelligents » plutôt que comme une IA au niveau d'une intelligence artificielle générale. Ils ont également souligné à plusieurs reprises le fait que cet article est basé sur une « première version » de GPT-4, qu'ils ont étudiée alors que l'IA était « encore en développement actif par OpenAI », et pas nécessairement la version qui a été transformée en formation applicable au produit.

Comme pour étayer ce propos, OpenAI a publié les résultats d'une étude sur l'impact économique du GPT-4 : 80 % de la main-d'œuvre américaine pourrait avoir au moins 10 % de ses tâches affectées par l'introduction des GPT, la série de grands modèles de langages populaires réalisés par OpenAI. Les chercheurs ont également estimé qu'environ 19 % des travailleurs verront au moins 50 % de leurs tâches affectées. L'exposition au GPT est plus élevée pour les emplois à revenu élevé, ont-ils écrit dans l'étude, mais s'étend à presque toutes les industries. Ils soutiennent que les modèles GPT sont des technologies à usage général comme la machine à vapeur ou la presse à imprimer.

L'article est baptisé « Les GPT sont des GPT : un premier aperçu du potentiel d'impact sur le marché du travail des grands modèles linguistiques ».

Un Gutenberg Moment du logiciel ?

Un Gutenberg Moment est un terme utilisé pour décrire une période de changement rapide et radical dans l'industrie de l'imprimerie. Cela fait référence à l'invention de Johannes Gutenberg de la presse à imprimer à caractères mobiles en 1440 qui a révolutionné l'industrie de l'imprimerie et a permis la production de livres en masse. Le terme est maintenant utilisé pour décrire des périodes de changement similaire dans d'autres industries.

Pour Paul Kedrosky et Eric Norlin de SK Ventures, nous sommes parvenus à un Gutenberg Moment dans le domaine de l'IA. Ce qui suit est extrait de leur billet sur le sujet.

Soudain, l'IA est devenue bon marché, au point que les gens la « gaspillent » via des invites « fais ma rédaction » envoyées aux chatbots, obtiennent de l'aide avec le code de microservice, etc. On pourrait dire que le rapport prix/performance de l'intelligence artificielle elle-même est en train de dégringoler, un peu comme cela s'est produit avec les générations précédentes de technologie.

On pourrait soutenir cela, mais c'est une vision trop étroite et orthodoxe, ou à tout le moins, incomplète et prématurée. Laissons de côté les questions d'éthique et d'alignement de l'intelligence artificielle générale (IAG). Il est probablement encore dans des années, au mieux, même s'il semble plus proche qu'il ne l'a été depuis des décennies. Dans cette optique, il convient de se rappeler que des vagues d'enthousiasme pour l'IA ont atteint la plage de prise de conscience une fois tous les dix ou deux ans, pour reculer à nouveau alors que l'hyperbole dépasse ce qui peut réellement être fait. Nous l'avons vu dans les années 1950 avec le travail (échoué) de Minsky, à nouveau dans les années 1970 avec le projet de cinquième génération (échoué) du Japon, et encore dans les années 2000 avec Watson (échoué) d'IBM. Si vous plissez les yeux très fort, vous pourriez voir un motif.

Pourtant, la croissance soudaine et émergente des LLM fait que certaines personnes passent beaucoup de temps à réfléchir aux professions de service qui peuvent être automatisées, ce que les économistes ont appelé l'automatisation du « déplacement ». Cela n'ajoute pas grand-chose à la réserve globale de valeur sociétale, et peut même être soustractif et déstabilisant, une sorte de moment d'externalisation du travail d'usine vers la Chine pour les cols blancs. Peut-être devrions-nous moins penser aux opportunités d'automatisation des déplacements et davantage aux opportunités d'augmentation de l'automatisation, le genre de chose qui libère la créativité et conduit à la richesse et à l'épanouissement humain.

Alors d'où cela viendra-t-il ? Nous pensons que ce boom de l'automatisation croissante viendra du même endroit que les précédents : d'un effondrement des prix de quelque chose alors que la productivité et les performances associées montent en flèche. Et ce quelque chose est un logiciel lui-même.

Par cela, nous ne voulons pas dire littéralement que les « logiciels » verront leurs prix baisser, comme s'il y aurait une guerre des prix induite par l'IA dans les traitements de texte comme Microsoft Word ou dans les microservices AWS. C'est une pensée linéaire et extrapolative. Cela dit, nous pensons que la frénésie actuelle d'injecter de l'IA dans chaque application ou service vendu sur terre suscitera plus de concurrence, pas moins. Pour ce faire, il augmentera les coûts des logiciels (chaque appel d'API d'IA est de l'argent dans les coffres de quelqu'un), tout en ne fournissant aucune différenciation réelle, étant donné que la plupart des fournisseurs s'appuieront sur les mêmes fournisseurs de ces appels d'API d'IA.

La maladie des coûts de Baumol et le problème des logiciels

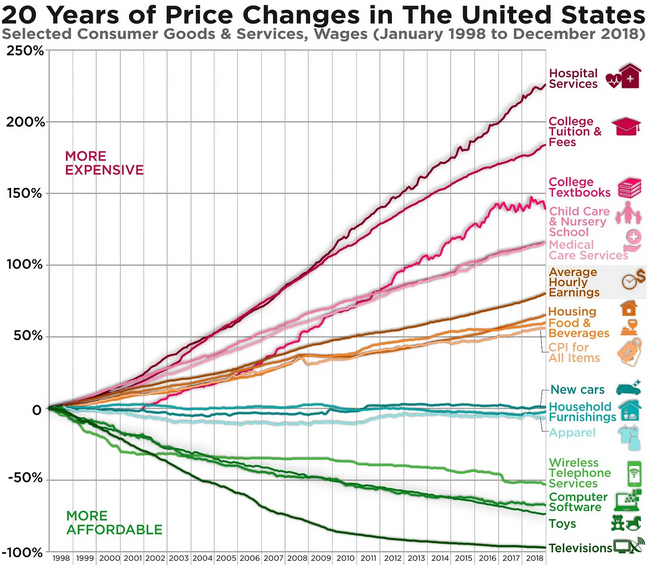

Comprendre ce que nous voulons dire nécessite un bref retour à quelques principes économiques de base. La plupart d'entre nous savent comment le prix des produits technologiques s'est effondré, tandis que les coûts de l'éducation et des soins de santé montent en flèche. Cela peut sembler un mystère exaspérant, avec des appels qui en résultent pour trouver de nouvelles façons de rendre ces industries plus proches de la technologie, ce par quoi les gens entendent généralement plus enclins aux forces déflationnistes de la technologie.

Mais c'est un malentendu. Pour expliquer : dans une économie hypothétique à deux secteurs, lorsqu'un secteur devient différemment plus productif, spécialisé et producteur de richesse, et l'autre non, il y a une pression énorme pour augmenter les salaires dans ce dernier secteur, de peur que de nombreux employés ne partent. Au fil du temps, ce secteur moins productif commence à devenir de plus en plus cher, même s'il n'est pas assez productif pour justifier des salaires plus élevés, alors il commence à « grignoter » de plus en plus de l'économie.

L'économiste William Baumol est généralement crédité de cette idée, et pour cela on l'appelle la maladie des coûts de Baumol. Vous pouvez voir la maladie des coûts dans la figure suivante, où divers produits et services (spoiler : principalement dans des secteurs à fort contact et à faible productivité) sont devenus beaucoup plus chers aux États-Unis, tandis que d'autres (non-spoiler : principalement basés sur la technologie ) sont devenus moins chers. Tout cela devrait avoir un sens maintenant, compte tenu des améliorations technologiques explosives par rapport à tout le reste. En fait, c'est presque une exigence mathématique.

En l'absence d'améliorations majeures de la productivité, qui ne peuvent provenir que de l'élimination des humains de ces services, il est difficile d'imaginer comment cela changera. Il est plus susceptible de continuer à s'aggraver, en supposant que nous voulons des soins de santé et de l'éducation à l'avenir, étant donné que l'essentiel de la valeur de ces services continuera d'être fourni par les humains.

Mais il y a un autre secteur qui est freiné par une variante de la maladie des coûts de Baumol, et c'est le logiciel lui-même. Cela peut sembler contradictoire, ce qui est compréhensible. Après tout, comment le secteur le plus productif, le plus générateur de richesse et déflationniste peut-il aussi être victime du même malaise qu'il inflige aux autres secteurs ?

Démographie, vieillissement et interruption de travail à venir des LLM

Nous pensons que tout est sur le point de changer. La génération actuelle de modèles d'IA est un missile visant, même involontairement, directement la production de logiciels elle-même. Bien sûr, les IA de chat peuvent très bien produire des essais de premier cycle ou créer des supports marketing et des articles de blog, mais ces technologies sont formidables au point de faire de la magie noire pour produire, déboguer et accélérer rapidement la production de logiciels presque sans frais.

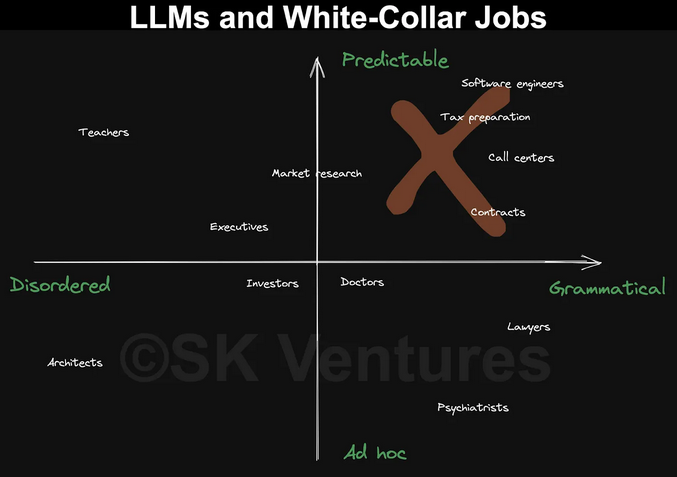

Et pourquoi ne le serait-il pas ? Comme le montre la figure suivante, les impacts du Large Language Model (LLM) sur le marché du travail peuvent être considérés comme une matrice 2x2. Le long d'un axe, nous avons à quel point le domaine est grammatical, c'est-à-dire à quel point les processus régissant la manipulation des symboles sont fondés sur des règles. Les essais, par exemple, ont des règles, donc les IA de chat basées sur les LLM peuvent être formées pour produire des essais étonnamment bons. Les fournisseurs de taxes, les contrats et de nombreux autres domaines se trouvent également dans cette case.

L'interruption de travail qui en résultera sera probablement immense, à la limite du sans précédent, dans ce quadrant supérieur droit au cours des prochaines années. Nous pourrions voir des millions d'emplois remplacés dans une multitude de professions, et le voir se produire plus rapidement que lors de toute vague d'automatisation précédente. Les implications seront innombrables pour les secteurs, pour les recettes fiscales et même pour la stabilité sociétale dans les régions ou les pays fortement tributaires de certaines des catégories d'emplois les plus touchées. Ces impacts larges et potentiellement déstabilisants ne doivent pas être sous-estimés et sont très importants.

Le logiciel est à l'épicentre de sa propre perturbation

Revenons au logiciel lui-même. Les logiciels sont encore plus basés sur des règles et ont plus de normes que l'anglais conversationnel ou toute autre langue conversationnelle. Les langages de programmation, de Python à C++, peuvent être considérés comme des langages formels avec un ensemble de règles très explicites régissant la façon dont chaque élément de langage peut et ne peut pas être utilisé pour produire un résultat souhaité. Les langages de programmation sont les plus méchants des bourrins de règles, ce qui est extrêmement frustrant pour de nombreux codeurs potentiels (Un ":" qui manque ?! C'était le problème ?! Flûte !), mais parfait pour les LLM comme ChatGPT.

Le deuxième axe de cette figure est tout aussi important. En plus de la grammaire sous-jacente, il y a aussi la prévisibilité du domaine. La même cause entraîne-t-elle toujours le même effet ? Ou le domaine est-il plus ad hoc, les causes précédant parfois les effets, mais pas toujours, et de manière imprévisible.

Encore une fois, la programmation est un bon exemple de domaine prévisible, créé pour produire les mêmes sorties avec les mêmes entrées. Si ce n'est pas le cas, il y a 99,9999 % de chances que ce soit de votre faute et non celui du langage. D'autres domaines sont beaucoup moins prévisibles, comme l'investissement en actions, la psychiatrie ou peut-être la météorologie.

Ce framework - grammaire vs prévisibilité - nous laisse convaincus que pour la première fois dans l'histoire de l'industrie du logiciel, des outils ont émergé qui vont radicalement modifier la façon dont nous produisons des logiciels. Il ne s'agit pas de faciliter le débogage, le test, la construction ou le partage (même si ceux-ci changeront également), mais de l'idée même de ce que signifie manipuler les symboles qui constituent un langage de programmation.

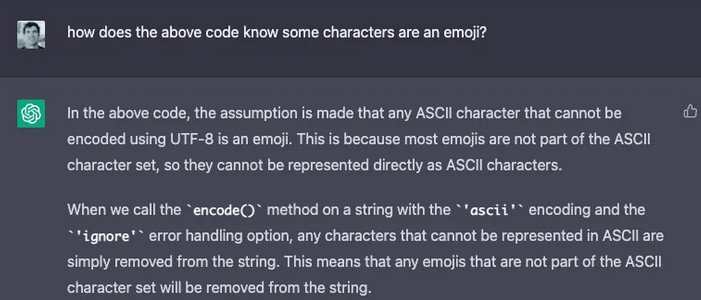

Soyons précis. Plutôt que d'avoir à apprendre Python pour analyser du texte et supprimer les emojis ASCII, par exemple, on pourrait littéralement écrire l'invite ChatGPT suivante :

Au cas où vous pensez, « il n'y a aucun moyen que cela fonctionne », vous vous trompez. Cela fonctionne bien, a pris deux secondes et n'est qu'un aperçu de la façon dont une habileté auparavant inaccessible pour écrire du code est désormais accessible à tous :Envoyé par ChatGPT

Pour dire l'évidence : c'est un exemple trivial, ennuyeux et stupide, même s'il est utile dans les bonnes circonstances chargées d'emoji. Ce n'est pas un code complexe. C'est simple au point d'être ennuyeux pour les praticiens qualifiés, tout en étant impossible pour la plupart des autres personnes, en l'absence de nombreuses visites sur les forums spécialisés.

Mais ça s'améliore et s'approfondit. Supposons que vous ne saviez pas pourquoi du code ne fonctionne pas, ou que vous pensiez qu'il fonctionnerait et que vous pensiez que l'IA bluffait peut-être. Vous pourriez lui demander de s'expliquer comme montré ici :

En bref, le LLM a utilisé un hack soigné. Au lieu de parcourir une liste exhaustive de tous les emojis ASCII et de voir s'ils sont présents, il a choisi d'utiliser des encodages de caractères pour différencier les emojis. C'est sacrément intelligent, et le fait que vous puissiez demander au LLM d'expliquer comment il a fait quelque chose - qu'il existe un pouvoir explicatif autoréférentiel - est une autre raison pour laquelle cela change le jeu logiciel.

Ce n'est que le début (et ça ne fera que s'améliorer). Il est possible d'écrire presque tous les types de code avec de telles technologies, des microservices réunissant divers services Web (une tâche pour laquelle vous auriez peut-être déjà payé un développeur 10 000 $ sur Upwork) à une application mobile complète (une tâche qui pourrait vous coûter 20 000 $ pour 50 000 $ ou plus).

À quoi ressemble une production de logiciels moins chère et moins complexe

Maintenant, soyons clairs. Pouvez-vous dire FAIS-MOI MICROSOFT WORD MAIS EN MIEUX, ou RÉSOUS CET ALGORITHME COMPSCI CLASSIC D'UNE NOUVELLE MANIÈRE ? Non, vous ne pouvez pas, ce qui amènera beaucoup à considérer ces technologies comme des jouets. Et ce sont des jouets dans un sens important. Ce sont des « jouets » en ce sens qu'ils sont capables de produire des extraits de code pour de vraies personnes, en particulier des non-codeurs, qu'un groupe incroyablement petit aurait pensé insignifiants, et un autre immense groupe aurait pensé impossible. Et ça change tout.

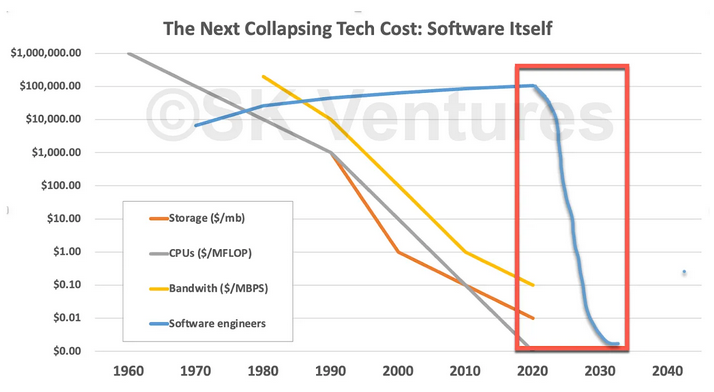

Comment ? Eh bien, d'une part, le prix de compensation pour la production de logiciels va changer. Mais pas seulement parce qu'il devient moins cher de produire des logiciels. À la limite, nous considérons ce moment comme étant analogue à la façon dont les vagues précédentes de changement technologique ont amené le prix des technologies sous-jacentes - des processeurs au stockage et à la bande passante - à une approximation raisonnable de zéro, déclenchant un flot de spéciation et d'innovation. En termes d'évolution logicielle, on vient de passer des temps de cycle humains à ceux de la drosophile : tout évolue et mute plus vite.

Voici l'une de nos expériences de pensée : que se passe-t-il si le coût de la production de logiciels suit des courbes similaires, peut-être même des courbes plus raides, et est sur le point de tomber à quelque chose comme zéro ? Et si produire un logiciel était sur le point de devenir une réflexion après coup, aussi naturelle que de s'expliquer dans un texte ? « J'ai besoin de quelque chose qui fasse X, pour Y, sans faire Z, pour iPhone, et si vous avez des idées pour le rendre moins que super moche, je suis tout ouïe ». Ce genre de chose.

Nous pouvons maintenant revoir nos courbes de coûts décroissantes antérieures et ajouter des logiciels à l'ensemble. Et si le coût de production des logiciels devait s'effondrer, pour toutes les raisons que nous avons évoquées, et malgré la maladie interne Baumol-ienne des coûts qui maintenait les coûts élevés ? Cela pourrait se produire très rapidement, plus rapidement que les générations précédentes, compte tenu de la rapidité avec laquelle les LLM évolueront.

Qu'est-ce que tout cela veut dire ? Nous n'avons rien contre les ingénieurs en logiciel et avons investi dans de nombreux brillants. Nous pensons cependant que le logiciel ne peut pas atteindre son plein potentiel sans échapper aux chaînes de l'industrie du logiciel, avec ses coûts élevés et, oui, sa productivité relativement faible. Une industrie du logiciel où n'importe qui peut écrire un logiciel, peut le faire pour quelques centimes et peut le faire aussi facilement que parler ou écrire un texte, est un moment de transformation. Il est exagéré, mais modeste, de dire que c'est une sorte de moment Gutenberg, un moment où les barrières antérieures à la création - savantes, créatives, économiques, etc. - vont tomber, à mesure que les gens sont libres de faire les choses, seulement limités par leur imagination, ou, plus concrètement, par les anciens coûts de production de logiciels.

Source : SK Ventures

Et vous ?

Que pensez-vous des arguments avancés par SK Ventures ?

Un Gutenberg Moment du logiciel ? Dans quelle mesure ?

Répondre avec citation

Répondre avec citation

Partager