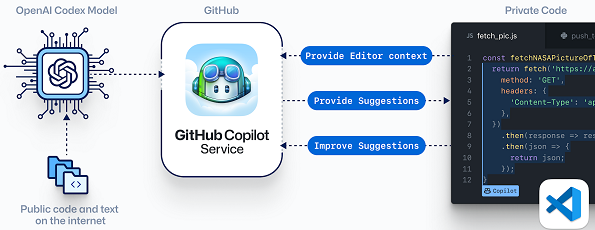

Aujourd'hui, nous avons déposé un recours collectif devant le tribunal fédéral américain de San Francisco, en Californie, au nom d'un groupe proposé de millions d'utilisateurs de GitHub. Nous contestons la légalité de GitHub Copilot (et d'un produit connexe, OpenAI Codex, qui alimente Copilot). La poursuite a été déposée contre un ensemble de défendeurs qui comprend GitHub, Microsoft (propriétaire de GitHub) et OpenAI.

En formant leurs systèmes d'IA sur des référentiels publics GitHub (bien que basés sur leurs déclarations publiques, peut-être bien plus), nous soutenons que les accusés ont violé les droits légaux d'un grand nombre de créateurs qui ont publié du code ou d'autres travaux sous certaines licences open source sur GitHub. Quelles licences ? Un ensemble de 11 licences open source populaires qui nécessitent toutes l'attribution du nom de l'auteur et des droits d'auteur, y compris la licence MIT, la GPL et la licence Apache. (Celles-ci sont énumérées dans l'annexe à la plainte.)

Répondre avec citation

Répondre avec citation

Qu'en pensez-vous ?

Qu'en pensez-vous ?

Partager