L'essor de l'IA pourrait révéler la stupidité naturelle des investisseurs, L’IA serait un boom technologique aux conséquences imprévisibles,

une révolution à double tranchant pour les marchés

Dans une analyse de l’impact de l’intelligence artificielle (IA) sur l’économie et les marchés financiers, le psychologue Amos Tversky, qui étudiait la « stupidité naturelle » est cité. Le texte montre comment l’IA a suscité un engouement et une spéculation excessifs, qui ont profité à certaines entreprises comme Nvidia, Microsoft ou Alphabet, mais qui ont aussi exposé les investisseurs à des risques de bulles et de mauvaises décisions. Il suggère que l’économie comportementale, qui étudie les biais et les erreurs humaines, peut aider à mieux comprendre et exploiter l’IA.

Pour Bill Gates, l'IA est l'avancée technologique la plus importante depuis des décennies.

Alors que la course au développement de services d'intelligence artificielle plus puissants tels que ChatGPT s'accélère, certains régulateurs s'appuient sur d'anciennes lois pour contrôler une technologie qui pourrait bouleverser le mode de fonctionnement des sociétés et des entreprises. L'Union européenne est à l'avant-garde de l'élaboration de nouvelles règles en matière d'IA qui pourraient servir de référence mondiale pour répondre aux préoccupations en matière de protection de la vie privée et de sécurité suscitées par les progrès rapides de la technologie d'IA générative qui sous-tend le service ChatGPT d'OpenAI. Mais il faudra plusieurs années pour que la législation soit appliquée.Envoyé par Bill Gates

« En l'absence de réglementation, la seule chose que les gouvernements peuvent faire est d'appliquer les règles existantes », a déclaré Massimilano Cimnaghi, expert européen en gouvernance des données au sein du cabinet de conseil BIP. « S'il s'agit de protéger des données personnelles, ils appliquent les lois sur la protection des données, s'il s'agit d'une menace pour la sécurité des personnes, il existe des réglementations qui n'ont pas été spécifiquement définies pour l'IA, mais elles sont toujours applicables. »

En avril, les organismes nationaux de surveillance de la vie privée en Europe ont mis en place un groupe de travail pour traiter les problèmes liés à ChatGPT après que le régulateur italien Garante a fait mettre le service hors ligne, accusant OpenAI de violer le GDPR de l'UE, un régime de protection de la vie privée de grande envergure promulgué en 2018. ChatGPT a été rétabli après que l'entreprise américaine a accepté d'installer des fonctions de vérification de l'âge et de laisser les utilisateurs européens bloquer leurs informations pour qu'elles ne soient pas utilisées pour entraîner le modèle d'IA.

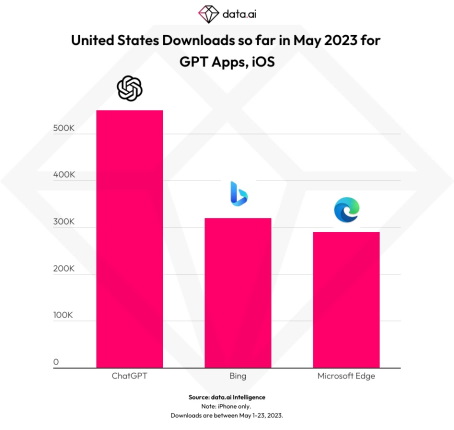

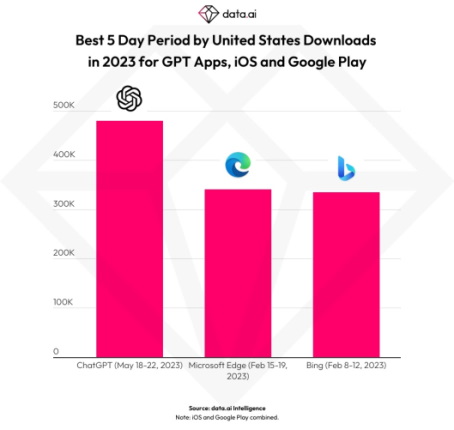

L’IA serait le seul moteur qui anime les marchés boursiers « déprimés » par la montée historique des taux d’intérêt américains

La semaine dernière, Manish Kabra, analyste chez SocGen, a calculé que sans les profits liés à l’IA, l’indice S&P 500 (.SPX) aurait chuté de 2 % depuis le début de l’année. Au contraire, il a progressé de 8 %. Le boom a même des impacts macroéconomiques.

Toujours la semaine dernière, le ministre irlandais des Finances, Michael McGrath, a dévoilé les plans d’un nouveau fonds souverain de 90 milliards d’euros, nourri en grande partie par une manne fiscale provenant des géants de la technologie comme Apple et Microsoft, qui ont leur siège dans le pays. Pour d’autres entreprises, les lacunes perçues face à l’IA peuvent être mortelles. Les actions de Chegg se sont effondrées au début du mois lorsque le fabricant de matériel d’étude a admis que les modèles de langage à grande échelle, comme ChatGPT, lui faisaient perdre des parts de marché.

Les modèles classiques d’évaluation des actifs suggèrent que ces variations excessives reflètent des évaluations fluctuantes, mais raisonnables de la rentabilité future. Mais l’économie comportementale offre depuis longtemps une autre explication en listant une série de biais systématiques dans la prise de décision humaine. Ces biais vont du comportement moutonnier et de la surconfiance au biais de confirmation et à la crainte de rater. C’est le moment pour les investisseurs d’être particulièrement vigilants à la tendance de la bêtise naturelle à pousser les valorisations boursières à des niveaux irréalistes - et donc finalement non rentables.

Cependant, les leçons les plus importantes de l'économie comportementale concernent une question plus fondamentale : la nouvelle génération d'IA tiendra-t-elle ses promesses ? La technologie a déjà obtenu des résultats impressionnants. En novembre 2020, AlphaFold de Google DeepMind a stupéfié le monde scientifique en réalisant une avancée dans l'un des grands défis de la biologie moléculaire. Il a prédit les structures dans lesquelles les protéines se "plient" en se basant uniquement sur les séquences des acides aminés qui les composent. Venki Ramakrishnan, lauréat du prix Nobel et président de la Royal Society britannique à l'époque, a qualifié cette avancée de « changement fondamental dans la recherche biologique ».

AlphaFold a démontré ce qui est généralement considéré comme la plus grande force de l'IA : sa capacité à reconnaître des modèles qui échappent à la fois à l'intuition humaine et à l'analyse statistique traditionnelle, puis à exploiter ces modèles à des fins prédictives. C'est cette même capacité qui a permis à l'IA de vaincre des adversaires humains dans des jeux stratégiques tels que les échecs et le go, et au ChatGPT de produire une prose étrangement cohérente.

La grande inconnue est de savoir si l'IA sera capable de reproduire cette extraordinaire possibilité de prédiction dans des domaines de la vie commerciale, financière et politique où les règles sont plus floues. L'économie comportementale propose quelques mises en garde contre les tentatives d'application sauvage de l'IA.

L'un des écueils potentiels est le problème du « biais d'échantillonnage » lors de la construction de modèles prédictifs basés sur l'apprentissage statistique. Le problème réside dans le fait que les ensembles de données utilisés pour former les modèles peuvent omettre des événements rares, mais importants. Par exemple, les rendements des marchés boursiers peuvent être influencés par un petit nombre de mouvements rares.

C'est pourquoi les sociétés de trading quantitatif ont souvent renoncé aux stratégies d'exploration de données pures au profit d'approches dans lesquelles la probabilité de ce que l'on appelle les risques de queue est supposée plutôt qu'apprise. Les investisseurs moins avertis sur le plan technique adoptent leur propre version de la même tactique lorsqu'ils déploient de simples heuristiques telles que la "marge de sécurité" du légendaire investisseur Benjamin Graham.

Les économistes comportementaux ont décrit le problème du biais d'échantillonnage en étudiant la manière dont les humains apprennent. Mais les réseaux neuronaux pourraient souffrir de défauts similaires. Les machines intelligentes, tout comme les humains naturellement stupides, devront faire face au fait irritant que l'absence de preuve n'est presque jamais une preuve d'absence.

Et puis il y a peut-être le problème le plus frustrant de tous lorsqu'il s'agit de modéliser et de manipuler le comportement humain : la loi de Goodhart. Il s'agit du paradoxe, énoncé pour la première fois par Charles Goodhart, fonctionnaire de la Banque d'Angleterre, en 1975, selon lequel lorsqu'une mesure devient un objectif politique, elle cesse d'être une mesure fiable. Par exemple, les agrégats monétaires étaient autrefois de bons indicateurs de l'inflation. Mais lorsque les banques centrales ont adopté des objectifs basés sur ces chiffres, la corrélation stable a disparu.

L'origine de ce problème réside dans le fait que les systèmes humains sont intrinsèquement adaptatifs, ce qui n'est pas le cas des systèmes physiques. Les gens comprennent et tentent de déjouer les efforts de prédiction de leur comportement s'ils sentent que cela va à l'encontre de leurs intérêts. Ce n'est pas le cas des acides aminés impliqués dans le pliage des protéines.

Une fois encore, ces défis pratiques sont bien documentés dans le domaine de l'investissement. La négociation de titres est un jeu à somme nulle : le gain en capital d'un investisseur est la perte en capital d'un autre. Par conséquent, il existe une incitation puissante et automatique pour le reste du marché à s'adapter et à annuler les règles de négociation qui ont fait leurs preuves dans le passé dès qu'elles sont identifiées. La loi de Goodhart explique pourquoi les rendements excédentaires des stratégies d'investissement systématiques s'érodent généralement avec le temps. La question de savoir si l'IA parviendra mieux à échapper à sa gravité reste ouverte.

Les investisseurs seraient bien en peine d'ignorer les résultats spectaculaires que l'IA a produits jusqu'à présent. Mais lorsqu'il s'agit d'applications plus larges, ils doivent faire preuve de prudence. L'intelligence artificielle pourrait avoir plus en commun avec la stupidité naturelle que les humains - ou les machines - ne le pensent actuellement.

Le texte montre que l’intelligence artificielle (IA) est un phénomène majeur qui transforme l’économie et les marchés financiers, mais qui comporte aussi des dangers et des défis. Il invite les investisseurs à ne pas se laisser emporter par l’enthousiasme irrationnel pour l’IA, mais à adopter une approche plus critique et plus prudente, en tenant compte des facteurs psychologiques, émotionnels et sociaux qui influencent leurs choix. Il suggère que l’économie comportementale, qui étudie la bêtise naturelle, peut être un outil utile pour mieux comprendre et exploiter l’IA.

Sources : Bill Gates, DT NEXT

Et vous ?

« L'essor de l'IA pourrait révéler la stupidité naturelle des investisseurs », partagez-vous cet avis ?

Quel est votre avis sur le sujet ?

Voir aussi :

Bill Gates affirme que l'essor de l'IA menace les bénéfices que Google tire de son moteur de recherche, mais la recherche via Bing Chat et Bard entraîne plusieurs milliards de dollars de surcoûts

Pour Bill Gates, l'IA est l'avancée technologique la plus importante depuis des décennies, il vient de publier une lettre de 7 pages sur l'IA et ses prédictions pour son avenir

Répondre avec citation

Répondre avec citation

.

.

Partager