Un outil de détection d'Intel utilise le flux sanguin pour identifier les deepfakes avec une précision de 96 %

l'outil s'appuie sur des processeurs Xeon Scalable de 3e génération

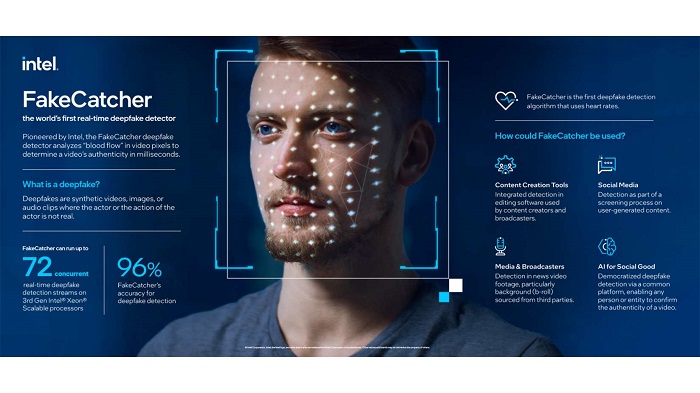

Intel a présenté lundi FakeCatcher, un détecteur de deepfakes, c'est-à-dire de médias synthétiques dans lesquels une personne figurant dans une image ou une vidéo existante est remplacée par la ressemblance d'une autre personne. La société estime que FakeCatcher est le premier détecteur en temps réel de deepfakes et affirme que le produit a un taux de précision de 96 %. Il fonctionne en analysant le "flux sanguin" subtil des pixels vidéo pour donner des résultats en quelques millisecondes. Intel affirme que son outil va rendre la détection de deepfakes plus rapide.

Les deepfakes font partie de ces technologies qui, bien qu'impressionnantes, sont souvent utilisées à mauvais escient, et leur popularité n'a cessé de croître au cours de ces dernières années. Les deepfakes, qui consistent généralement à superposer le visage et la voix d'une personne sur une autre, ont commencé à attirer l'attention il y a quelques années lorsque les sites Web pour adultes ont commencé à bannir les vidéos où cette technique était utilisée pour ajouter le visage d'actrices célèbres au corps de stars du porno. Mais les techniques de deepfake sont devenues de plus en plus sophistiquées au fil des ans, rendant la détection plus difficile.

Il existe désormais de nombreuses applications qui permettent aux utilisateurs d'insérer le visage de leurs amis dans des films, et l'on a vu le processus piloté par l'IA utilisé pour redonner vie à d'anciennes photos et faire apparaître à l'écran de jeunes versions d'acteurs. Les entreprises et les chercheurs travaillent depuis des années sur des moyens de distinguer une vidéo authentique d'une vidéo altérée, mais la nouvelle solution d'Intel semble être l'une des plus efficaces et innovantes. Ilke Demir, chercheuse principale au sein d'Intel Labs, a conçu FakeCatcher en collaboration avec Umur Ciftci de l'université d'État de New York à Binghamton.

Le produit utilise du matériel et des logiciels Intel, fonctionne sur un serveur et s'interface via une plateforme Web. Des organisations, dont Facebook, le ministère américain de la Défense, Adobe et Google, ont créé des outils destinés à identifier les deepfakes. Ces outils se basent généralement sur l'apprentissage profond afin d'examiner les données brutes pour repérer l'inauthenticité. Mais Intel adopte une méthode différente. La plateforme d'Intel utilise l'apprentissage profond pour analyser les subtils changements de couleur du visage causés par le sang qui circule dans les veines, un processus appelé photopléthysmographie, ou PPG.

La méthode permet de mesurer la quantité de lumière absorbée ou réfléchie par les vaisseaux sanguins dans les tissus vivants. Lorsque le cœur pompe le sang, celui-ci va dans les veines, qui changent de couleur. FakeCatcher observe le flux sanguin dans les pixels d'une image, ce que les deepfakes doivent encore perfectionner, et examine les signaux de plusieurs images. Il soumet ensuite les signatures à un classificateur. Ce dernier détermine si la vidéo en question est réelle ou fausse. Intel affirme que cette technique peut déterminer si une vidéo est réelle en quelques millisecondes et avec un taux de précision de 96 %.

La société ajoute que la plateforme utilise des processeurs Xeon Scalable de 3e génération avec jusqu'à 72 flux de détection simultanés et fonctionne via une interface Web. Avec FakeCatcher, les signaux PPG sont collectés à 32 endroits du visage puis des cartes PPG sont créées à partir des composantes temporelles et spectrales. Une solution en temps réel avec un taux de précision aussi élevé pourrait faire une différence considérable dans la guerre en ligne contre la désinformation. Mais d'un autre côté, cette technologie pourrait aussi rendre les "deepfakes" encore plus réalistes, les créateurs essayant de tromper le système.

« Vous ne pouvez pas le voir avec vos yeux, mais il est visible sur le plan informatique. Les signaux PPG sont connus, mais ils n'ont jamais été appliqués au problème du deepfake auparavant. Nous prenons ces cartes et entraînons un réseau neuronal convolutif au-dessus des cartes PPG pour les classer comme fausses et réelles. Et ensuite, grâce aux technologies Intel comme le framework Deep Learning Boost pour l'inférence et Advanced Vector Extensions 512, nous pouvons l'exécuter en temps réel et jusqu'à 72 flux de détection simultanés », a déclaré Demir. (Une détection de plus en plus importante face à des menaces croissantes).

Selon un récent document de recherche d'Eric Horvitz, directeur scientifique de Microsoft, la détection de deepfake est devenue de plus en plus importante au cours de ces dernières années. Il s'agit notamment des deepfakes interactifs, donnant l'illusion de parler à une personne réelle, et des deepfakes de composition, où les mauvais acteurs créent de nombreux deepfakes pour compiler une "histoire synthétique". En 2020, Forrester Research a prédit que les coûts associés aux escroqueries par deepfake dépasseraient 250 millions de dollars. Plus récemment, les informations sur les deepfakes de célébrités ont proliféré.

D'un autre côté, il existe de nombreux cas d'utilisation responsable et autorisée des deepfakes. Des sociétés telles que Hour One et Synthesia proposent des deepfakes pour les entreprises - pour la formation des employés, l'éducation et le commerce électronique, par exemple. Les deepfakes peuvent également être créés par des utilisateurs tels que des célébrités et des chefs d'entreprise qui souhaitent profiter des médias synthétiques pour "sous-traiter" à un jumeau virtuel. Dans ces cas-là, on peut espérer qu'un moyen d'assurer une transparence et une provenance complètes des médias synthétiques verra le jour.

Demir a déclaré qu'Intel mène des recherches, mais qu'elles n'en sont qu'à leurs débuts. « FakeCatcher fait partie d'une équipe de recherche plus importante chez Intel, appelée Trusted Media, qui travaille sur la détection des contenus manipulés, la génération responsable et la provenance des médias. À court terme, la détection est la solution aux deepfakes et nous développons plusieurs détecteurs différents basés sur différents indices d'authenticité, comme la détection du regard. L'étape suivante après cela sera la détection de la source, ou la recherche du modèle GAN qui se trouve derrière chaque deepfake », a-t-elle déclaré.

« Le point d'or de ce que nous envisageons est d'avoir un ensemble de tous ces modèles d'IA, afin de pouvoir fournir un consensus algorithmique sur ce qui est faux et ce qui est vrai », a ajouté Demir. Bien que Demir et son équipe se montrent enthousiastes sur le sujet, il est important de noter que la détection des deepfakes s'avère difficile sur plusieurs fronts. Selon une étude menée en 2021 par l'Université de Californie du Sud, certains des ensembles de données utilisés pour former les systèmes de détection des "deepfakes" peuvent sous-représenter les personnes d'un certain sexe ou d'une certaine couleur de peau.

Selon l'étude, ce biais peut être amplifié dans les détecteurs de deepfake, certains détecteurs montrant jusqu'à 10,7 % de différence dans le taux d'erreur en fonction du groupe racial. Et en 2020, des scientifiques de Google et de l'Université de Californie à Berkeley ont montré que même les meilleurs systèmes d'IA formés pour distinguer les contenus réels et synthétiques étaient sensibles aux attaques adverses qui les conduisaient à classer les fausses images comme réelles. À cela s'ajoute le jeu permanent du chat et de la souris entre les créateurs de deepfakes et les détecteurs.

Mais Demir a déclaré qu'à l'heure actuelle, FakeCatcher d'Intel ne peut être déjoué. « L'extraction PPG que nous utilisons n'est pas différentiable, vous ne pouvez pas simplement la brancher sur la fonction de perte d'un réseau antagoniste, car cela ne fonctionne pas et vous ne pouvez pas rétrocéder si elle n'est pas différentiable. Si vous ne voulez pas apprendre l'extraction PPG exacte, mais que vous voulez l'approcher, vous avez besoin d'énormes ensembles de données PPG, qui n'existent pas pour le moment. Il y a [des ensembles de données de] 30-40 personnes qui ne sont pas généralisables à l'ensemble », a-t-elle déclaré.

Source : Intel

Et vous ?

Quel est votre avis sur le sujet ?

Que pensez-vous de l'outil de détection de deepfake d'Intel ?

Voir aussi

Des chercheurs développent une IA capable de détecter les vidéos deepfake avec une précision allant jusqu'à 99 %, cette méthode détecte les expressions faciales manipulées et les échanges d'identité

Des cybercriminels ont utilisé la technologie deepfake pour voler 35 millions de dollars à une banque, en clonant la voix du directeur

Facebook lance le Deepfake Detection Challenge, un concours avec plus de 10 millions de dollars à la clé, visant à faire avancer la recherche en matière de lutte contre les contenus manipulés

Les arnaques de type deepfake et crypto ont augmenté durant le premier trimestre 2022, ils sont utilisés pour diffuser de la désinformation et accéder à des informations financières ou personnelles

Répondre avec citation

Répondre avec citation

Partager