Google dévoile son IA génératrice d'images par le texte baptisée Imagen

et affirme qu'elle est meilleure que DALL-E 2 d'OpenAI

Il y a une nouvelle tendance en vogue dans l'IA : les générateurs d'image par le texte; alimentez ces programmes avec le texte que vous aimez et ils généreront des images remarquablement précises qui correspondent à cette description. Le monde de l'IA cherche toujours à gérer l'incroyable démonstration de prouesses qu'apporte la capacité de DALL-E 2 à dessiner / peindre / imaginer à peu près n'importe quoi… mais OpenAI n'est pas le seul à travailler sur le sujet; Google Research s'est empressé de publier un modèle similaire sur lequel il travaillait. Résultat : Google affirme qu'Imagen produit des images toujours meilleures que DALL-E 2, sur la base d'un nouveau benchmark qu'il a créé pour ce projet nommé DrawBench.

L'intelligence artificielle a souvent affronté les humains dans des combats créatifs. Il peut battre les grands maîtres aux échecs, créer des symphonies, produire des poèmes et, désormais, créer des œuvres d'art détaillées à partir d'une courte invite écrite. L'équipe d'OpenAI a récemment créé un logiciel puissant, capable de produire une large gamme d'images en quelques secondes, juste à partir d'une chaîne de mots qui lui est donnée. Ce programme est connu sous le nom de Dall-E 2 et a été conçu pour révolutionner la façon dont nous utilisons l'IA avec les images.

Que fait le Dall-E 2 ?

En 2021, la société de développement de la recherche sur l'IA OpenAI a créé un programme connu sous le nom de «Dall-E» - un mélange des noms Salvador Dali et Wall-E. Ce logiciel a été capable de prendre une invite écrite et de créer une image générée par l'IA complètement unique. Par exemple, « un renard dans un arbre » ferait apparaître une photo d'un renard assis dans un arbre, ou l'invite « astronaute avec un bagel à la main » montrerait… eh bien, vous voyez où cela mène.

Bien que ce soit certainement impressionnant, les images étaient souvent floues, pas tout à fait précises et prenaient un certain temps à créer. Maintenant, OpenAI a apporté de vastes améliorations au logiciel, créant Dall-E 2 - une nouvelle itération puissante qui fonctionne à un niveau beaucoup plus élevé.

Outre quelques autres nouvelles fonctionnalités, la principale différence avec ce deuxième modèle est une énorme amélioration de la résolution de l'image, des latences plus faibles (le temps nécessaire à la création de l'image) et un algorithme plus intelligent pour créer les images.

Le logiciel ne se contente pas de créer une image dans un style unique, vous pouvez ajouter différentes techniques artistiques à votre demande, en entrant des styles de dessin, de peinture à l'huile, un modèle en pâte à modeler, tricoté en laine, dessiné sur un mur de grotte, ou même comme une affiche de film des années 1960.

« Dall-E est un assistant très utile qui amplifie ce qu'une personne peut normalement faire, mais cela dépend vraiment de la créativité de la personne qui l'utilise. Un artiste ou quelqu'un de plus créatif peut créer des choses vraiment intéressantes », explique Aditya Ramesh, l'un des ingénieurs principaux de Dall-E 2.

Un touche-à-tout

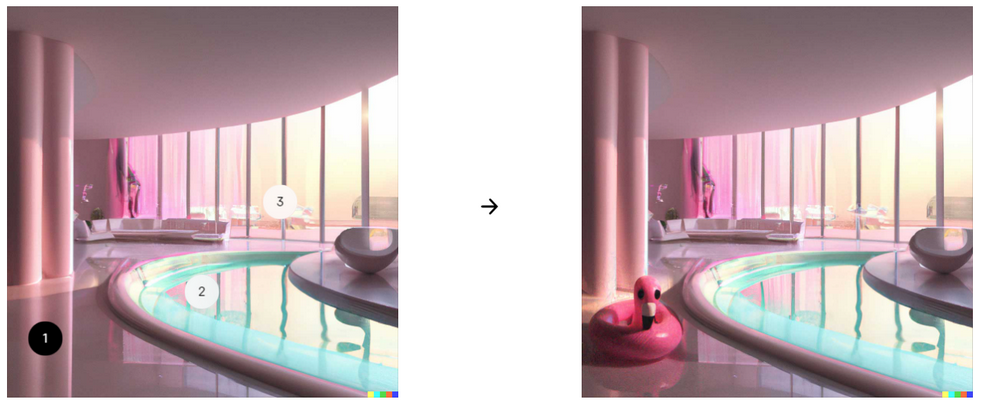

En plus de la capacité de la technologie à produire des images uniquement sur des invites textuelles, Dall-E 2 dispose de deux autres techniques intelligentes : l'inpainting (le nom donné à la technique de reconstruction d'images détériorées ou de remplissage des parties manquantes d'une image) et les variations. Ces deux applications fonctionnent de manière similaire au reste de Dall-E, juste avec une touche.

Avec l'inpainting, vous pouvez prendre une image existante et y ajouter de nouveaux éléments ou en modifier des parties. Si vous avez une image d'un salon, vous pouvez ajouter un nouveau tapis, un chien sur le canapé, changer le tableau au mur ou même faire apparaître un éléphant dans la pièce… parce que quelqu'un pourrait y penser, voyez vous.

à gauche, l'image originale, à droite l'édition Dall-E 2. Les chiffres 1, 2 et 3 donne un exemple d'illustration de placement d'un élément (en l'occurrence le flamant). Vous pouvez modifier sa position

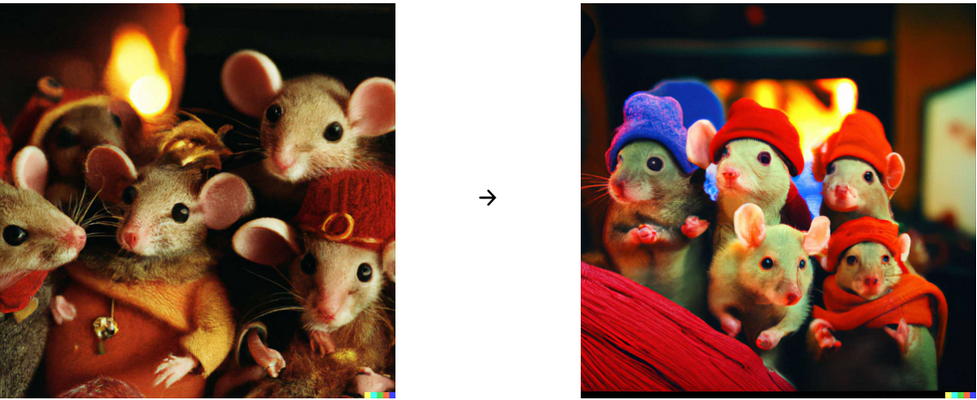

Variations est un autre service qui nécessite une image existante. Insérez une photo, une illustration ou tout autre type d'image et l'outil de variation de Dall-E créera des centaines de ses propres versions. Vous pouvez lui donner une image d'un des télétubbies, et il la reproduira, créant des versions similaires. Une vieille peinture d'un samouraï créera des images similaires, vous pouvez même prendre une photo de certains graffitis que vous voyez et obtenir des résultats similaires.

Vous pouvez également utiliser cet outil pour combiner deux images en une seule. Mélangez un dragon et un corgi, ou un arc-en-ciel et un pot pour générer des pots avec de la couleur.

à gauche l'image originale, à droite, l'outil variation de Dall-E 2 appliqué sur cette image

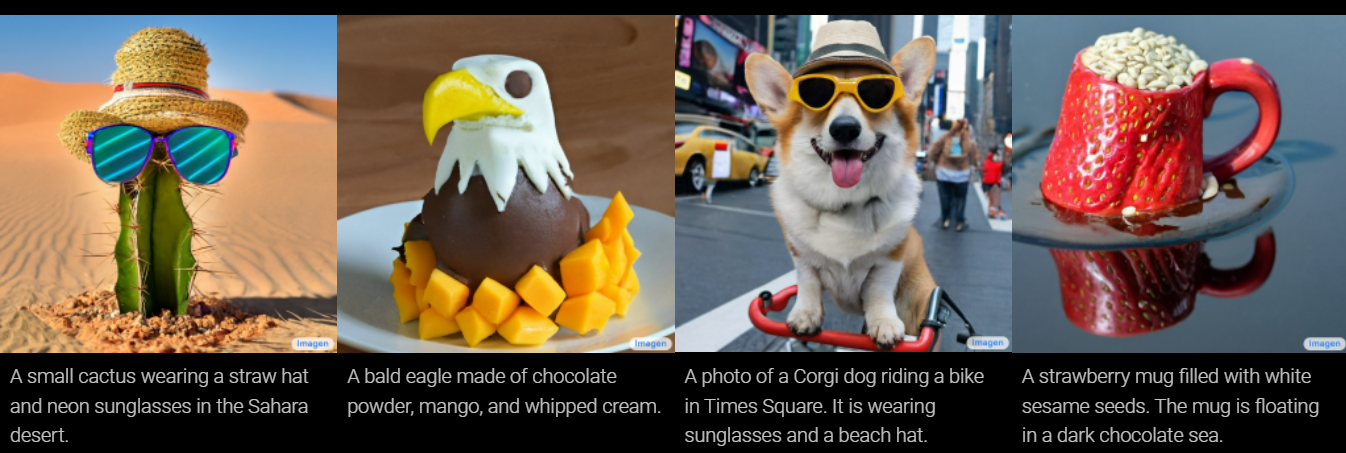

Google affirme avoir fait mieux avec Imagen

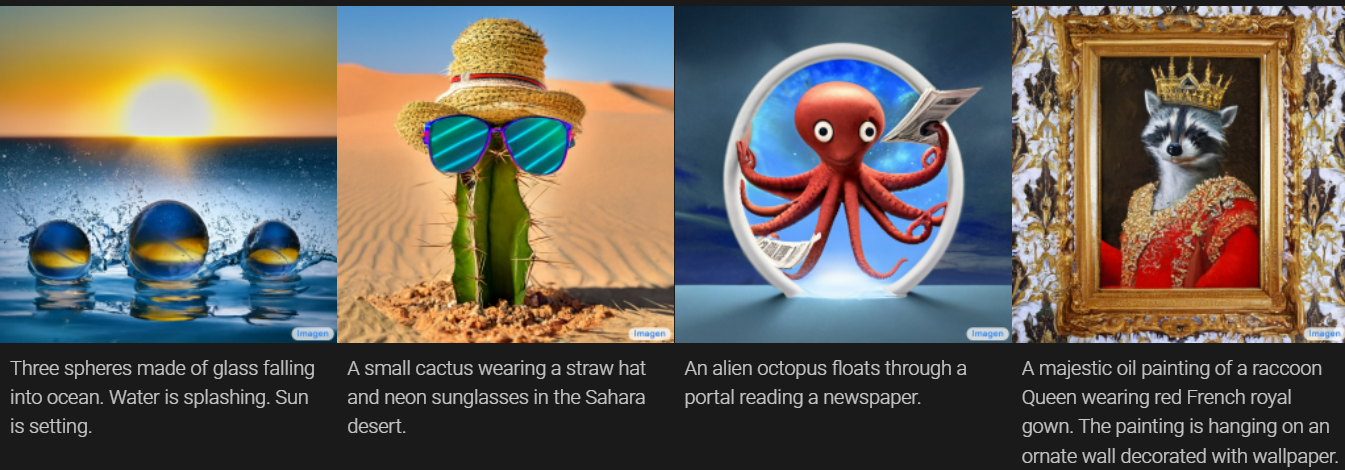

« Nous présentons Imagen, un modèle de diffusion texte-image avec un degré de photoréalisme sans précédent et un niveau profond de compréhension du langage. Imagen s'appuie sur la puissance des modèles de langage à grands transformateurs pour comprendre le texte et s'appuie sur la force des modèles de diffusion dans la génération d'images haute fidélité ».

Imagen commence par générer une petite image (64 × 64 pixels) puis effectue deux passages en « super résolution » dessus pour l'amener à 1024 × 1024. Cependant, ce n'est pas comme une mise à l'échelle normale, car la super-résolution de l'IA crée de nouveaux détails en harmonie avec l'image plus petite, en utilisant l'original comme base.

Supposons, par exemple, que vous ayez un chien à vélo et que l'œil du chien mesure 3 pixels de diamètre dans la première image. Pas beaucoup de place pour l'expression ! Mais sur la deuxième image, c'est 12 pixels de large. D'où viennent les détails nécessaires pour cela? Eh bien, l'IA sait à quoi ressemble l'œil d'un chien, elle génère donc plus de détails au fur et à mesure qu'elle dessine. Ensuite, cela se reproduit lorsque l'œil est refait, mais à 48 pixels de diamètre.

Les avancées que les chercheurs de Google revendiquent avec Imagen sont multiples. Ils disent que les modèles de texte existants peuvent être utilisés pour la partie d'encodage du texte et que leur qualité est plus importante que la simple augmentation de la fidélité visuelle. Cela a du sens intuitivement, car une image détaillée d'un non-sens est certainement pire qu'une image légèrement moins détaillée de ce que vous avez demandé exactement.

Dans les tests de Google, notamment le benchmark DrawBench, Imagen est arrivé en tête des tests d'évaluation humaine, à la fois sur la précision et la fidélité. C'est évidemment assez subjectif, mais égaler la qualité perçue de DALL-E 2, qui jusqu'à aujourd'hui était considérée comme un énorme bond en avant par rapport à tout le reste, est assez impressionnant.

DrawBench n'est pas une métrique particulièrement complexe : il s'agit essentiellement d'une liste de quelque 200 invites de texte que l'équipe de Google a introduites dans Imagen et d'autres générateurs de texte en image, la sortie de chaque programme étant ensuite jugée par des évaluateurs humains. Comme le montrent les graphiques ci-dessous, Google a constaté que les humains préféraient généralement la sortie d'Imagen à celle de leurs rivaux.

Limites et impact sociétal

« Il existe plusieurs défis éthiques auxquels est confrontée la recherche text-to-image au sens large. Nous proposons une exploration plus détaillée de ces défis dans notre article et proposons une version résumée ici. Premièrement, les applications en aval des modèles texte-image sont variées et peuvent avoir un impact complexe sur la société. Les risques potentiels d'utilisation abusive soulèvent des inquiétudes concernant l'open source responsable du code et des démos. Pour le moment, nous avons décidé de ne pas publier de code ou de démo publique. Dans les travaux futurs, nous explorerons un cadre d'externalisation responsable qui équilibre la valeur de l'audit externe avec les risques d'un libre accès illimité. Deuxièmement, les exigences en matière de données des modèles texte-image ont conduit les chercheurs à s'appuyer fortement sur de vastes ensembles de données, pour la plupart non conservés et récupérés sur le Web. Bien que cette approche ait permis des avancées algorithmiques rapides ces dernières années, les ensembles de données de cette nature reflètent souvent des stéréotypes sociaux, des points de vue oppressifs et des associations désobligeantes ou autrement nuisibles à des groupes identitaires marginalisés. Alors qu'un sous-ensemble de nos données de formation a été filtré pour supprimer le bruit et le contenu indésirable, tels que les images pornographiques et le langage toxique, nous avons également utilisé l'ensemble de données LAION-400M qui est connu pour contenir un large éventail de contenus inappropriés, notamment des images pornographiques, des insultes racistes et stéréotypes sociaux néfastes. Imagen s'appuie sur des encodeurs de texte entraînés sur des données non curées à l'échelle du Web, et hérite ainsi des préjugés sociaux et des limites des grands modèles de langage. En tant que tel, il existe un risque qu'Imagen ait encodé des stéréotypes et des représentations nuisibles, ce qui guide notre décision de ne pas publier Imagen pour un usage public sans autres garanties en place.

« Enfin, bien qu'il y ait eu un travail approfondi d'audit des modèles d'étiquetage image-texte et image pour les formes de préjugés sociaux, il y a eu relativement moins de travail sur les méthodes d'évaluation des préjugés sociaux pour les modèles texte-image. Un vocabulaire conceptuel autour des dommages potentiels des modèles texte-image et des mesures d'évaluation établies sont un élément essentiel de l'établissement de pratiques responsables de publication de modèles. Bien que nous laissions une analyse empirique approfondie des préjugés sociaux et culturels aux travaux futurs, nos évaluations internes à petite échelle révèlent plusieurs limites qui guident notre décision de ne pas publier notre modèle pour le moment. Imagen, peut courir le risque de laisser tomber les modes de distribution des données, ce qui peut encore aggraver la conséquence sociale du biais des ensembles de données. Imagen présente de sérieuses limitations lors de la génération d'images représentant des personnes. Nos évaluations humaines ont révélé qu'Imagen obtient des taux de préférence significativement plus élevés lorsqu'il est évalué sur des images qui ne représentent pas de personnes, ce qui indique une dégradation de la fidélité de l'image. L'évaluation préliminaire suggère également qu'Imagen encode plusieurs préjugés et stéréotypes sociaux, y compris un biais général en faveur de la génération d'images de personnes à la peau plus claire et une tendance pour les images représentant différentes professions à s'aligner sur les stéréotypes de genre occidentaux. Enfin, même lorsque nous nous concentrons sur des générations éloignées des personnes, notre analyse préliminaire indique qu'Imagen encode une gamme de préjugés sociaux et culturels lors de la génération d'images d'activités, d'événements et d'objets. Nous visons à progresser sur plusieurs de ces défis ouverts et limites dans les travaux futurs ».

Conclusion

Il sera cependant difficile de juger de la conclusion de Google par nous-mêmes, car Google ne met pas le modèle Imagen à la disposition du public. Il y a aussi une bonne raison à cela. Bien que les modèles texte-image aient certainement un potentiel créatif fantastique, ils ont également une gamme d'applications troublantes. Imaginez un système qui génère à peu près n'importe quelle image que vous aimez être utilisée pour de fausses nouvelles, des canulars ou du harcèlement, par exemple. Comme le note Google, ces systèmes codent également les préjugés sociaux et leur production est souvent raciste, sexiste ou toxique d'une autre manière inventive.

Cela est dû en grande partie à la façon dont ces systèmes sont programmés. Essentiellement, ils sont formés sur d'énormes quantités de données (dans ce cas : beaucoup de paires d'images et de légendes) qu'ils étudient pour établir des modèles qu'ils apprennent à reproduire. Mais ces modèles ont besoin de beaucoup de données, et la plupart des chercheurs – même ceux qui travaillent pour des grandes enseignes de la technologie bien financées comme Google – ont décidé qu'il était trop onéreux de filtrer de manière exhaustive cette entrée. Ainsi, ils récupèrent d'énormes quantités de données sur le Web et, par conséquent, leurs modèles ingèrent (et apprennent à répliquer) toute la bile haineuse que vous vous pouvez vous attendre à trouver en ligne.

La propre conclusion de Google est qu'Imagen « n'est pas adapté à un usage public pour le moment », et la société a déclaré qu'elle prévoyait de développer une nouvelle façon de comparer « les préjugés sociaux et culturels dans les travaux futurs » et de tester les futures itérations. Pour l'instant, cependant, nous devrons nous contenter de la sélection optimiste d'images de l'entreprise.

Source : Google

Et vous ?

Que pensez-vous en général de la création d'image en sortie par du texte en entrée ?

De DALL-E 2 et Imagen, lequel à votre préférence ? Dans quelle mesure ?

Voyez-vous des abus potentiels ? Lesquels ?

Que pensez-vous des solutions de mitigations proposées par les entreprises ?

Répondre avec citation

Répondre avec citation

Partager