Google se dégrade-t-il ? Les critiques affirment que les annonces et les sites de spam tuent la recherche

l'IA de Google n'aiderait pas non plus à avoir de bons résultats

Un nombre croissant de personnes continuent d'affirmer que Google serait en train de mourir. À en croire ce qu'ils disent, les résultats de recherche de Google seraient de plus en plus truffés de publicités payantes et les sites Web de spam parviennent de mieux en mieux à se hisser dans les résultats de recherche en déjouant les algorithmes de l'entreprise. Le résultat final serait que la recherche Google se détériore progressivement, devenant moins utile et plus ennuyeuse.

Les résultats de recherche de Google seraient de moins en moins fiables

Au début des années 2000, Google a su rapidement séduire les gens en raison de la facilité avec laquelle il pouvait indexer n'importe quel site Web n'importe où dans le monde. Cet outil de recherche en ligne permettait d'accéder à tout ce qu'une personne pouvait attendre d'Internet. Pour certains, les mots "Internet" et "Google" se confondaient, tandis que pour d'autres, ils étaient une seule et même chose. À cette époque, l'entreprise a connu un grand succès et s'est développée rapidement en quelques années. Aujourd'hui encore, pour le commun des mortels, Internet tourne autour d'un simple mot : "Google".

Cependant, certains initiés pensent que Google n'est plus vraiment ce qu'il était, sa régie publicitaire influençant grandement les résultats de recherche au grand dam des internautes. Les résultats de Google seraient de plus en plus "affinés" afin de répondre aux 80 % de requêtes les plus populaires, tout en devenant bien pires pour les requêtes techniques ou complexes. « Une fois que vous avez dépassé la première ou la deuxième page, les résultats sont encore pires, avec des pages sans aucun rapport avec la requête (par exemple, elles ne contiennent même pas les phrases recherchées) », a déclaré l'un des critiques du moteur de recherche.

« Ils sont probablement en train de tester ou ont déjà mis en œuvre une sorte d'optimisation de type bandit à plusieurs bras, comme pour les résultats de recherche de YouTube, où ils affichent simplement toutes les pages populaires (sans tenir compte de la pertinence) pour voir si elles donnent lieu à un clic », a-t-il ajouté. D'autres estiment qu'en 2000, Google serait devenu populaire parce que les hackers ont réalisé qu'il était meilleur que Lycos (un moteur de recherche lancé en 1994) ou Excite (une collection de sites et services Web, lancée en1995). Mais en raison de ces problèmes, les utilisateurs précoces utiliseraient de moins en moins Google.

« Un petit problème médical récent a mis en évidence à quel point quelqu'un doit perturber la recherche Google. Google ne produit plus des résultats de recherche de haute qualité dans un nombre significatif de catégories importantes. La santé, les critiques de produits et les recettes sont trois catégories dans lesquelles j'ai effectué des recherches aujourd'hui et où les premiers résultats présentaient des sites de type "clickbait" ("putaclic" ou "piège à clics") criblés de publicités pourries. Je suis sûr qu'il y en a beaucoup d'autres », a écrit sur Twitter en janvier Michael Seibel, partenaire chez Y Combinator et directeur général de YC Early Stage.

La publicité et le SEO seraient les principaux problèmes de Google

Selon les critiques, les algorithmes de Google seraient en train de mourir en raison de la publicité, des spams, du SEO (search engine optimization - optimisation des moteurs de recherche) et de l'IA. Dmitri Kyle Brereton, ingénieur logiciel et écrivain, affirme "qu'il est évident que la diffusion d'annonces crée des incitations mal alignées pour les moteurs de recherche. Les fondateurs de Google l'auraient eux-mêmes souligné tout au début de leur activité". En 1998, Sergey Brin et Larry Page auraient déclaré : « actuellement, le modèle économique prédominant pour les moteurs de recherche commerciaux est la publicité ».

« Les objectifs du modèle économique publicitaire ne correspondent pas toujours à la fourniture d'une recherche de qualité aux utilisateurs. Nous nous attendons à ce que les moteurs de recherche financés par la publicité soient intrinsèquement biaisés en faveur des annonceurs et loin des besoins des consommateurs. En outre, les revenus publicitaires incitent souvent à fournir des résultats de recherche de mauvaise qualité ». D'après les critiques, ces réflexions sur les défaillances des moteurs de recherche financés par la publicité se lisent comme un manuel d'instructions pour ce que Google a fait ensuite.

Page et Brin ont commencé à vendre des annonces à côté de leurs résultats de recherche dès le début des années 2000 et, depuis, les activités publicitaires de Google n'ont cessé de croître. Les annonces diffusées sur le réseau de Google - qui comprend YouTube et les placements d'annonces sur des sites tiers - auraient rapporté à la société la somme astronomique de 54 milliards de dollars au cours du premier trimestre 2022. Cela pourrait lui rapporter jusqu'à 180 milliards de dollars au cours de l'année 2022. « Ils ont récemment poussé le bouchon au maximum afin de soutirer jusqu'au dernier centime avant leur effondrement inévitable », a déclaré Brereton.

Les critiques sur la qualité et la pertinence des résultats de recherche ont considérablement augmenté ces derniers mois. Cependant, un porte-parole de Google a fait valoir cette année que "la qualité de Google Search s'est considérablement améliorée au fil du temps". « Chaque année, nous apportons des milliers d'améliorations à Google, et nos tests nous donnent des preuves claires que ces changements rendent vraiment la recherche meilleure pour les internautes. Au cours des sept dernières années, nous avons diminué les résultats non pertinents de plus de 50 % », a déclaré le porte-parole.

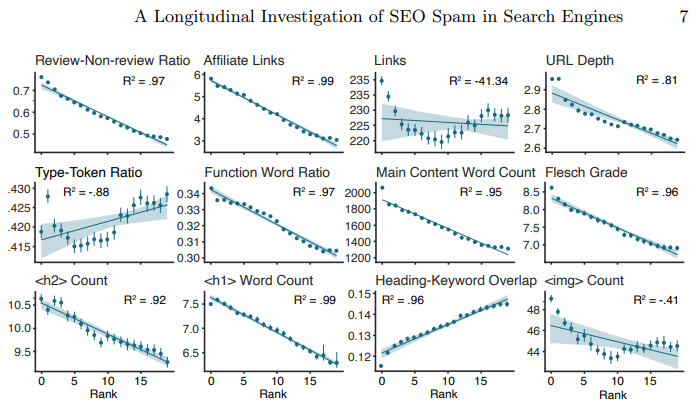

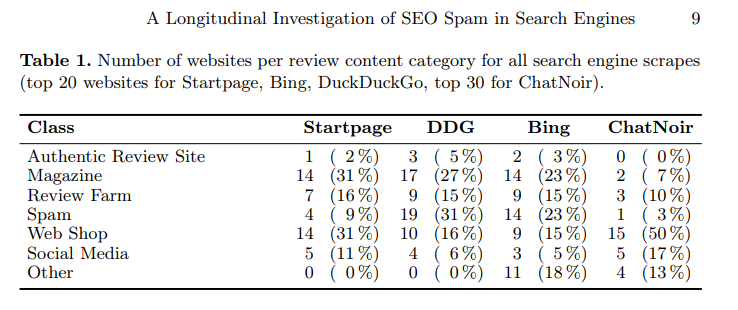

Quant au SEO, les critiques, y compris Brereton, affirment qu'il existe des milliers de personnes dont le seul travail consiste à jouer avec les algorithmes pour atteindre le sommet d'une page de résultats de Google. « Il ne faut donc pas s'étonner de la détérioration de la qualité des résultats de recherche. Pour être franc, ce problème se poserait probablement avec n'importe quel moteur de recherche, mais on s'attendrait à ce que Google soit capable de mettre au point un algorithme qui soit moins manipulable », a écrit Brereton dans un billet de blogue en février dernier.

Enfin, alors que Google tente de rendre son moteur de recherche plus "intelligent" grâce à l'intelligence artificielle, les critiques accusent l'IA de biaiser les résultats de recherche. « De plus en plus, Google ne vous donne pas les résultats correspondant à ce que vous avez tapé. Il essaie d'être intelligent et de comprendre ce que vous avez "vraiment voulu dire", en plus de personnaliser les choses pour vous. Si vous vouliez vraiment dire exactement ce que vous avez tapé, alors les jeux sont faits. Même l'opérateur de recherche de correspondance exacte (" ") ne donne plus de correspondance exacte, ce qui est assez bizarre », a déclaré Brereton.

À propos des alternatives potentielles à Google, Brereton affirme que Bing et DuckDuckGo souffrent de nombreux problèmes similaires à ceux de Google, tels que le spam et les publicités liés aux algorithmes. Selon lui, les nouvelles alternatives les plus intéressantes sont les sites Neeva, Brave et You.com. Brave a abandonné récemment le moteur de recherche de Google au profit de son propre moteur de recherche.

Cependant, les critiques estiment que la mainmise de Google sur le marché de la recherche rend difficile l'émergence d'un concurrent. « L'alternative ne peut pas être simplement deux fois meilleure, elle doit être tellement meilleure que cela vaut la peine de changer de site », suggère Brereton.

Sources : Dmitri Kyle Brereton, exemples de résultats Google biaisés recensés en Norvège

Et vous ?

Quel est votre avis sur le sujet ?

Pensez-vous que la recherche sur Google se dégrade ?

Que pensez-vous des problèmes de Google relevés par les internautes ?

Avez-vous identifié d'autres problèmes dont souffre le moteur de recherche de Google ?

Google peut-il trouver un compromis avantageux entre la recherche et la publicité ?

Selon vous, l'utilisation de l'IA par Google améliore-t-il les résultats de recherche ?

Voir aussi

Le navigateur Brave supprime Google comme moteur de recherche par défaut et le remplace par son propre moteur de recherche

Le projet Dragonfly, le moteur de recherche controversé de Google pour le marché chinois, « a été abandonné », selon un représentant de l'entreprise

Quel moteur de recherche pourrait être le prochain Google ? Voici comment certains essaient de détrôner le géant de Mountain View

Les bénéfices d'Alphabet (Google) ont chuté de plus d'un milliard de dollars par rapport à 2021, suite au ralentissement de la croissance de la publicité sur YouTube et son moteur de recherche

Répondre avec citation

Répondre avec citation

Partager