Le PDG d'Epic Games met en garde contre la "surveillance d'État" d'Apple

alors qu'Epic Games est détenu en partie par Tencent en Chine

Les nouvelles fonctionnalités d'Apple pour la protection élargie des enfants sont l'objet de nombreux débats dans l'industrie depuis leur annonce la semaine passée. Un des commentaires les plus notables est celui de Tim Sweeney, PDG d'Epic Games, qui a déclaré samedi qu'Apple est en train de mettre en place des "logiciels espions du gouvernement" et qu'il serait vraisemblablement "un bras de la surveillance de l'État partout où cela est nécessaire". Sweeney critique Apple, alors qu'Epic Games est détenu à 48 % par Tencent, très souvent accusé d'aider le PCC en matière de censure et de surveillance des citoyens chinois.

Tim Sweeney lance régulièrement des piques à l'endroit d'Apple depuis quelques années, notamment sur la façon dont l'entreprise maintient son écosystème fermé. La situation s'est envenimée l'année dernière lorsqu'Apple a éjecté la franchise Fortnite d'Epic Games de l'App Store, après que le second a tenté de contourner les 30 % de commission prélevés par le premier sur tous les achats in-app. Le week-end dernier, Sweeney a lancé de nouvelles critiques à l'encontre des nouvelles politiques d'Apple en matière de sécurité et de la protection des enfants, qualifiant ces mesures de "logiciel espion du gouvernement".

Le débat découle d'une annonce faite par Apple jeudi. En théorie, l'idée est assez simple : Apple veut lutter contre les abus sexuels sur les enfants, et prend davantage de mesures pour les détecter et les arrêter. Mais les critiques disent que la stratégie d'Apple pourrait affaiblir le contrôle des utilisateurs sur leurs propres téléphones, les laissant dépendre de la promesse d'Apple de ne pas abuser de son pouvoir. La réponse d'Apple a mis en lumière la complexité - et parfois la confusion - de cette conversation. Apple a en effet annoncé trois changements qui seront mis en œuvre dans le courant de l'année.

Ils sont tous liés à la lutte contre les abus sexuels à l'encontre des enfants, mais visent des applications différentes dotées de fonctionnalités différentes. La première fonctionnalité concerne l'application de recherche d'Apple et Siri. Si un utilisateur recherche des sujets liés aux abus sexuels sur les enfants, Apple l'orientera vers des ressources permettant de les signaler ou d'obtenir de l'aide en cas d'attirance pour ce type d'abus. Cette mesure sera mise en œuvre plus tard cette année sur iOS 15, watchOS 8, iPadOS 15 et macOS Monterey, et elle ne suscite guère de controverse.

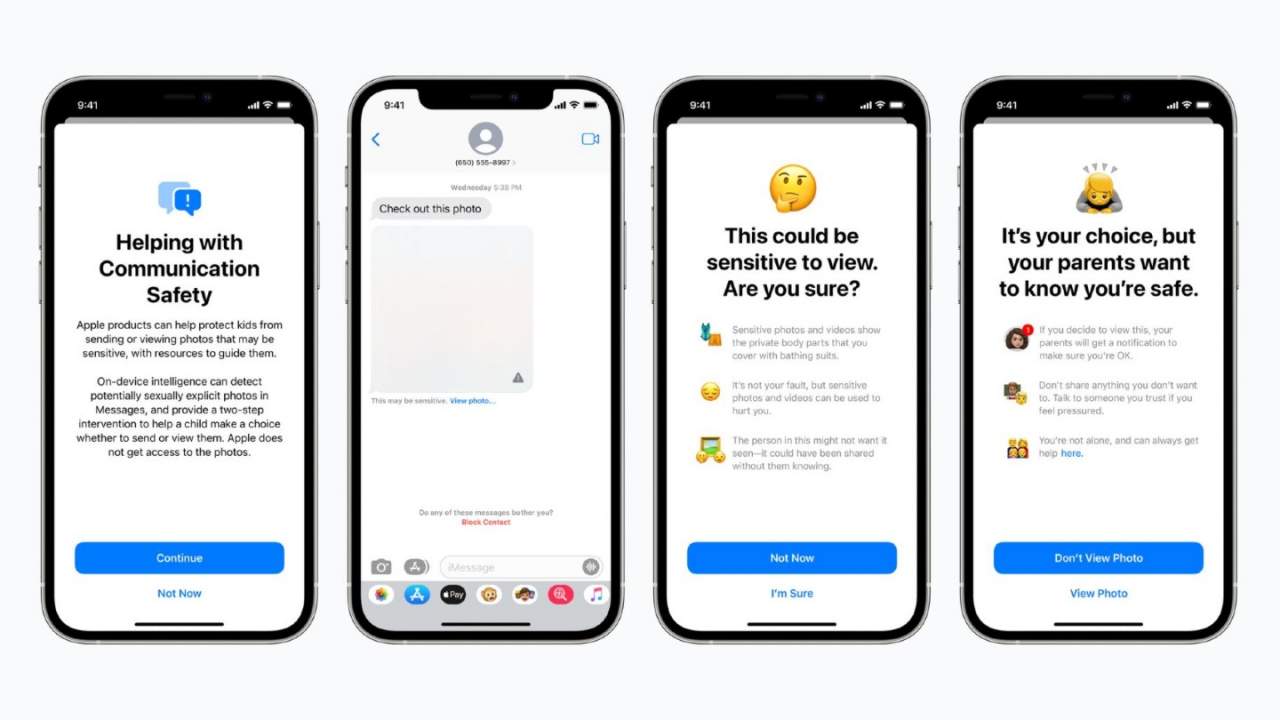

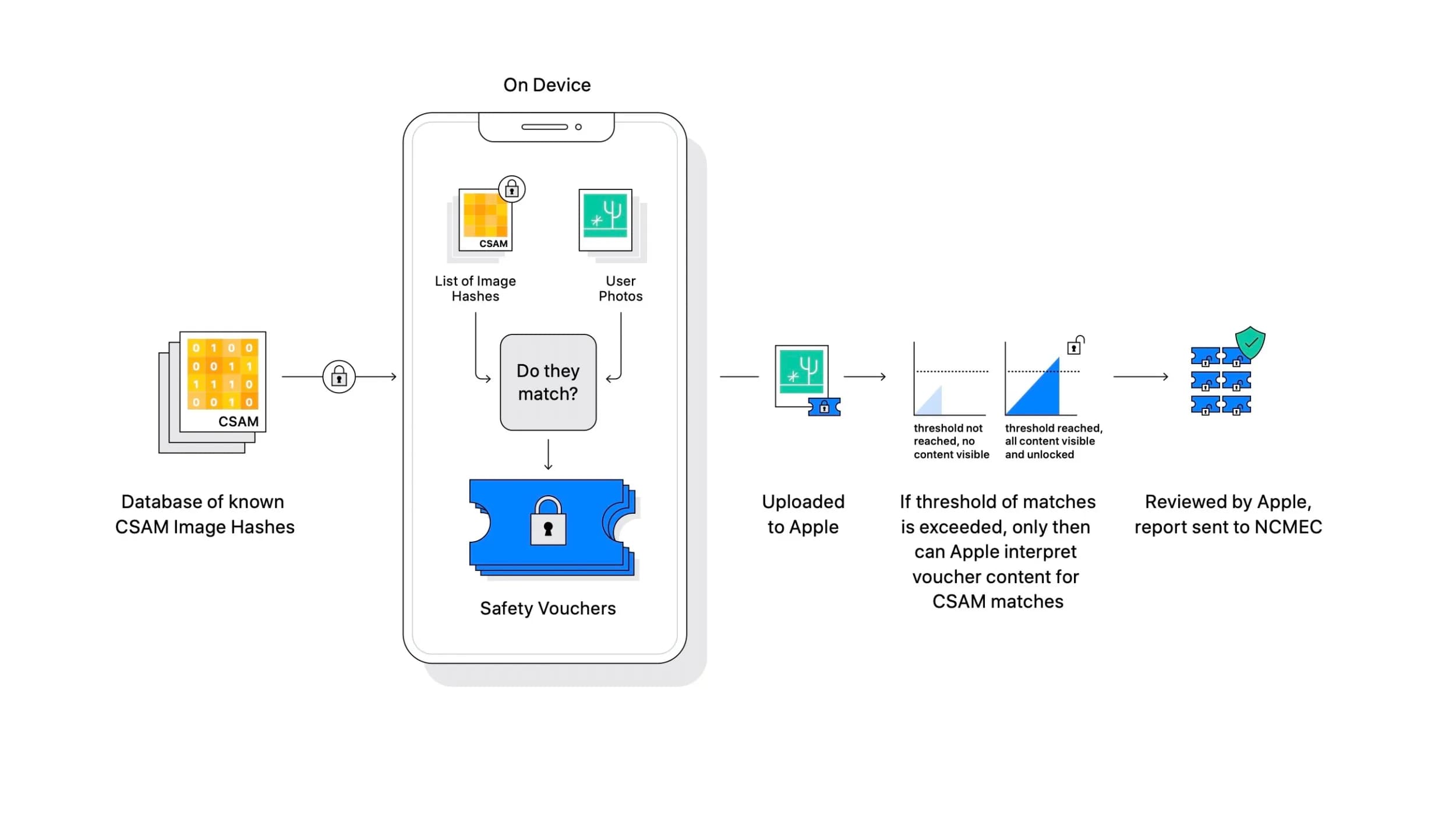

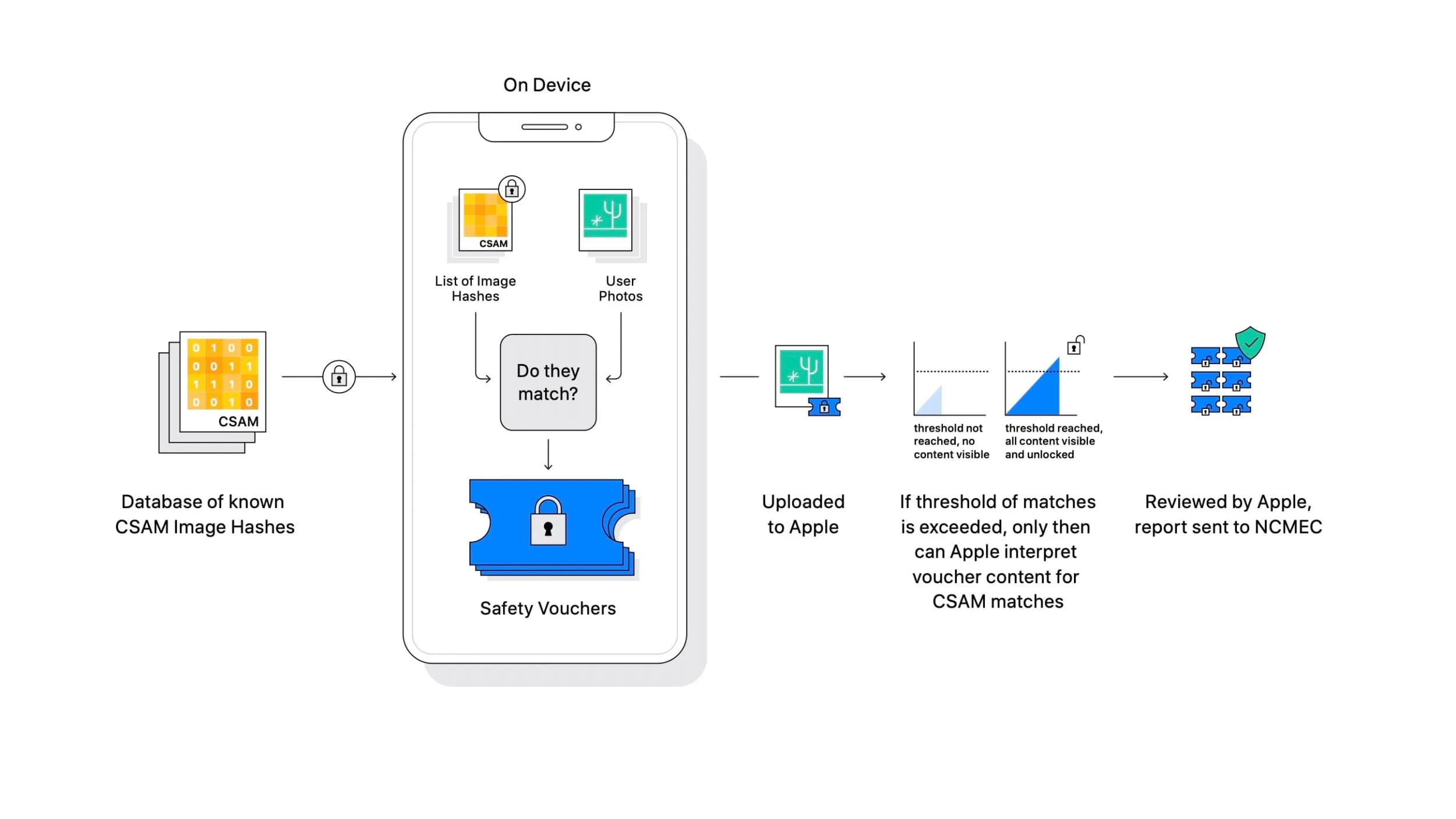

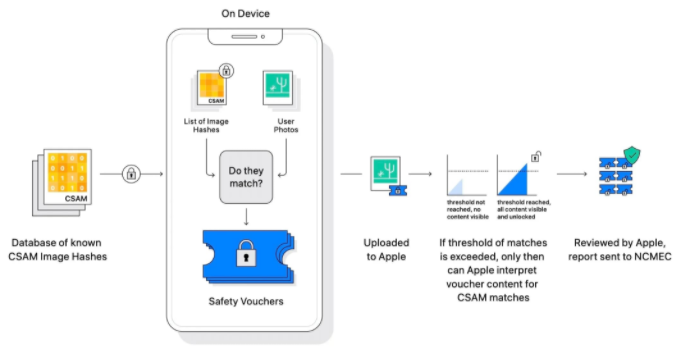

Les autres mises à jour, en revanche, ont suscité beaucoup plus de réactions négatives. L'une d'elles ajoute une option de contrôle parental à Messages, masquant les photos sexuellement explicites pour les utilisateurs de moins de 18 ans et envoyant aux parents une alerte si un enfant de 12 ans ou moins consulte ou envoie ces photos. La dernière fonctionnalité analyse les images d'iCloud Photos pour y trouver du matériel pédopornographique (CSAM - Child sexual abuse content), et le signale aux modérateurs d'Apple - qui peuvent le transmettre au National Center for Missing and Exploited Children (NCMEC).

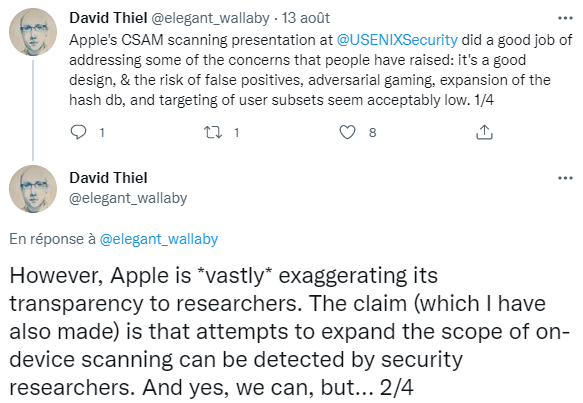

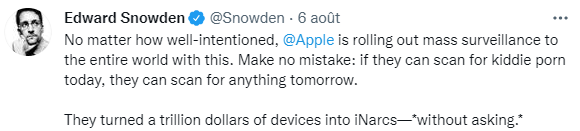

Apple affirme avoir conçu cette fonctionnalité spécifiquement pour protéger la vie privée des utilisateurs tout en détectant les contenus illégaux. Les critiques disent que cette même conception équivaut à une porte dérobée de sécurité. Le projet, qui devrait prendre vie aux États-Unis avant d'être étendu au reste du monde, a suscité l'indignation et la communauté dénonce une surveillance de masse orchestrée par Apple. À la suite des commentaires de L'EFF (Electronic Frontier Foundation), de journalistes, de chercheurs en sécurité et de consommateurs mécontents, c'est au tour de Sweeney.

« J'ai essayé de voir ça du point de vue d'Apple. Mais inéluctablement, il s'agit d'un logiciel espion du gouvernement installé par Apple sur la base d'une présomption de culpabilité. Bien qu'Apple ait écrit le code, sa fonction est de scanner les données personnelles et de les rapporter au gouvernement. C'est totalement différent d'un système de modération de contenu sur un forum public ou un média social. Avant que la société ne choisisse d'héberger les données publiquement, il peut les scanner pour détecter ce qu'il ne veut pas héberger. Mais il s'agit de données privées de personnes », a critiqué Sweeney sur Twitter.

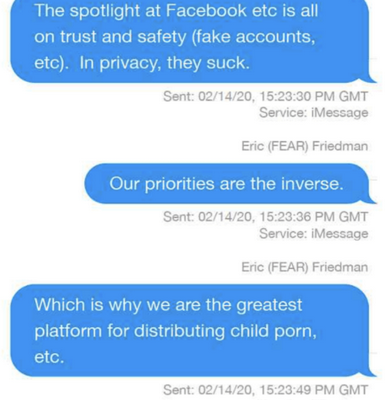

Mais encore, le PDG milliardaire a également critiqué la plateforme iCloud d'Apple qui télécharge par défaut les données des utilisateurs, ce qui fait que les gens accumulent des "données indésirables". En outre, Sweeney a averti que partout l'entreprise s'installera, Apple "devra se conformer à toutes les lois applicables partout où elle fait des affaires". « Par conséquent, l'on peut supposer qu'Apple sera désormais un bras de la surveillance de l'État partout où cela est nécessaire », a-t-il ajouté. De même, il a également abordé dans ses commentaires, les critiques concernant les compromis d'Apple en matière de vie privée en Chine.

Dans un jeu de mots sur "pensez aux enfants", il a déclaré : « Pensez à la dystopie dans laquelle ils grandiront si nous tolérons la croissance incontrôlée de monopoles privés dotés d'un pouvoir de surveillance illimité et assumant de plus en plus des rôles de gouvernement, sans pour autant être soumis aux processus démocratiques libéraux ». Il a souligné que de nombreux utilisateurs d'Apple ont été obligés de s'inscrire pour obtenir une adresse électronique iCloud dans le cadre des protocoles d'inscription précédents, et a prédit que le sentiment public sera manipulé pour soutenir l'initiative.

« La liberté est fondée sur une procédure régulière et un gouvernement limité. La menace existentielle ici est une alliance impie entre le gouvernement et les monopoles qui contrôlent le discours en ligne et les appareils de chacun, en utilisant l'apparence de sociétés privées pour contourner les protections constitutionnelles », a déclaré Sweeney. Cependant, Sweeney s'est rapidement vu reprocher de faire deux poids, deux mesures, car Epic Game est détenu à près de 48 % par le géant technologique chinois Tencent, un groupe technologique chinois dont les rapports avec le PCC font l'objet de plusieurs controverses.

Tencent est soupçonné d'avoir collaboré avec le gouvernement chinois pour surveiller les utilisateurs non chinois et censurer le contenu de l'application de messagerie WeChat. Une étude a révélé que le géant chinois aurait surveillé le contenu politique posté par des comptes étrangers pour former ses algorithmes de censure pour les utilisateurs nationaux. La recherche montre non seulement comment Tencent pratique la censure, mais aussi informe et développe ses propres stratégies de censure. En outre, d'autres rapports notent que l'entreprise est susceptible de soutenir les recherches politiques du gouvernement.

« Si le gouvernement chinois a besoin de réguler l'opinion publique, il utilisera certainement la base de données des contenus politiquement sensibles de WeChat pour apprendre », a déclaré un professionnel basé à Pékin qui a travaillé en étroite collaboration avec le gouvernement. Un rapport du Wall Street Journal datant décembre 2020 décrivait la plateforme WeChat de Tencent comme "l'un des outils les plus puissants de l'arsenal de Pékin pour surveiller le public, censurer les discours et punir les personnes qui expriment leur mécontentement à l'égard du gouvernement". Tencent a toutefois toujours nié ces allégations.

Une autre controverse est liée à la récente décision de Tencent d'utiliser la reconnaissance faciale pour empêcher les jeunes enfants de jouer à des jeux vidéo après l'heure du coucher. Par ailleurs, Sweeney's n'est que l'une des nombreuses voix qui demandent à Apple de reconsidérer ses plans. Des défenseurs de la vie privée et des experts en sécurité ont signé une lettre ouverte demandant l'arrêt des nouvelles mesures qui rechercheront le contenu de CSAM dans les photos iCloud sur les appareils des utilisateurs aux États-Unis, puis dans le monde.

Source : Tim Sweeney

Et vous ?

Quel est votre avis sur le sujet ?

Que pensez-vous des propos de Tim Sweeney ?

Voir aussi

Apple envisage un système de détection d'images d'abus d'enfants dans la galerie de photos des utilisateurs, mais les chercheurs en sécurité craignent une surveillance de masse des iPhone

Le lanceur d'alerte Edward Snowden et l'EFF critiquent le projet d'Apple de scanner les messages et les images iCloud. Des milliers de personnes demandent à l'entreprise de suspendre ses plans

Dans un mémo interne, Apple répond aux préoccupations concernant les nouvelles fonctions de balayage des photos, alors que les experts dénoncent un recul dans les progrès en matière de vie privée

Répondre avec citation

Répondre avec citation

Partager