Meta dévoile Llama 2 Long AI, une version améliorée du logiciel libre Llama 2, plus performant que GPT-3.5 Turbo et Claude 2 dans des tâches spécifiques

Meta a discrètement lâché une bombe dans le monde de l'IA avec l'introduction de Llama 2 Long, un nouveau modèle d'IA qui surpasse GPT-3.5 Turbo et Claude 2 dans des tâches spécifiques. Cette révélation a eu lieu lors de la conférence annuelle Meta Connect à Menlo Park, en Californie.

La véritable histoire n'est pas celle de cette conférence, mais celle d'un article d'informatique discrètement rangé sur le site pas si exclusif que cela, arXiv.Org. Les chercheurs de Meta semblent avoir un talent pour faire des annonces révolutionnaires avec peu de publicité. L'article présente Llama 2 Long, une version améliorée du logiciel libre Llama 2 de Meta. Cette IA s'est apparemment rendue à la salle de sport et a suivi un entraînement intensif, ce qui lui a permis d'acquérir des pouvoirs surhumains.

Comment le Llama 2 Long a-t-il vu le jour ?

Les chercheurs ont pris le Llama 2 original, qui se présente sous la forme de différents paramètres d'entraînement, comme une boîte de chocolats. Ils ont décidé de l'alimenter avec des sources de données textuelles plus étendues. Pour être précis, ils ont ajouté 400 milliards de tokens de données. C'est comme si vous donniez à votre modèle d'IA un festin littéraire.

Mais voici le clou du spectacle : ils n'ont pas touché à l'architecture du Llama 2. Non, ils n'ont rien touché. Seule une "modification nécessaire" a été apportée au codage de la position. En d'autres termes, le codage positionnel est l'équivalent du GPS pour l'intelligence artificielle. Il aide les enfants à déterminer où se trouvent les objets les uns par rapport aux autres. Dans cet exemple, ils ont utilisé une technique connue sous le nom de "Rotary Positional Embedding" (RoPE). C'est comme si l'on passait d'une carte papier à un appareil GPS de haute technologie. Ils ont simplement changé l'angle de rotation du RoPE du lama 2 au lama 2 long, et voilà ! Soudain, l'IA a pu identifier les tokens les plus éloignés, ces solitaires qui ne s'entendent pas avec les autres.

Pour rendre Llama 2 Long encore plus innovant, les chercheurs ont ajouté un peu d'apprentissage par renforcement à partir du feedback humain (RLHF). C'est comme apprendre de nouveaux tours à un chien, sauf que ces tours impliquent le codage, les mathématiques, la compréhension du langage, le raisonnement de bon sens et la réponse à des questions posées par des humains. L'IA est récompensée lorsqu'elle obtient de bons résultats et les humains vérifient ses devoirs. Tout le monde y gagne, l'IA comme les humains qui la dirigent.

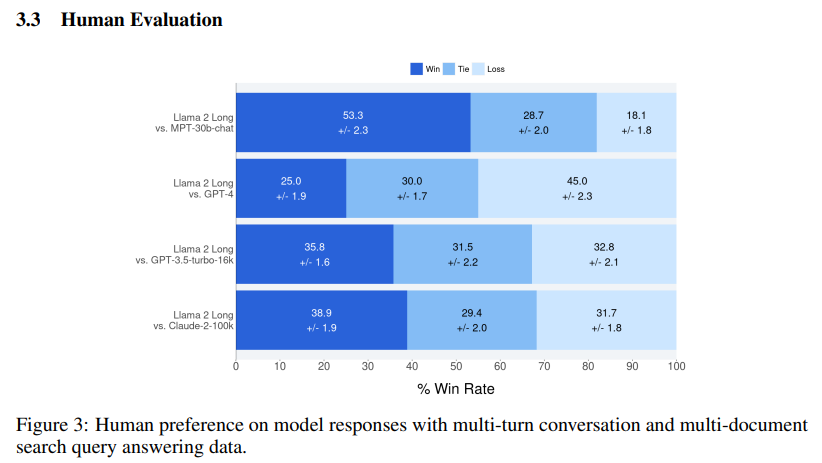

La question principale est maintenant de savoir pourquoi tout le monde parle de Llama 2 Long. Le Llama 2 Long est le nec plus ultra des tâches quotidiennes effectuées par les grands modèles de langage (LLM). Il surpasse non seulement son petit frère, Llama 2, mais aussi les puissants GPT-3.5 Turbo et Claude 2. C'est un peu comme si le nouveau venu se présentait comme le champion en titre.

La communauté de l'IA open-source, qui n'est pas du genre à dissimuler ses sentiments, a couvert Llama 2 Long d'admiration et d'enthousiasme. Reddit, Twitter et Hacker News se sont transformés en équipes de pom-pom girls virtuelles pour l'approche "open source" de Meta en matière d'IA. C'est un peu comme l'histoire classique de David contre Goliath, où l'open source s'oppose aux modèles fermés et "pay-to-play" défendus par les startups aux poches pleines.

En conclusion, Meta a changé la donne dans le domaine de l'IA avec Llama 2 Long. Cette centrale d'IA est l'équivalent numérique d'un super-héros, qui surpasse ses concurrents et vole la vedette. Llama 2 Long a captivé le cœur de la communauté open-source et donne du fil à retordre aux plus grands grâce à ses capacités remarquables.

Source : Effective Long-Context Scaling of Foundation Models

Et vous ?

Que pensez-vous de ce nouveau modèle d'IA de Meta ?

Voir aussi :

Le modèle LLamA-2 de Meta, qui vient d'être publié, ne serait pas open source, de l'avis de Alessio Fanelli, Ingénieur logiciel associé chez Decibel

Alibaba, le géant technologique chinois, lance un modèle d'IA en libre accès pour tenter de concurrencer le Llama 2 de Meta

Falcon 180B : un modèle d'IA open source avec 180 milliards de paramètres entraînés sur 3 500 milliards de jetons, il serait plus performant que le modèle Llama 2 de Meta et égale PaLM-2 de Google

Répondre avec citation

Répondre avec citation

Partager