Les effets subtils de la circulation sanguine peuvent être utilisés pour détecter un deepfake et le logiciel qui a permis de le créer,

selon une étude

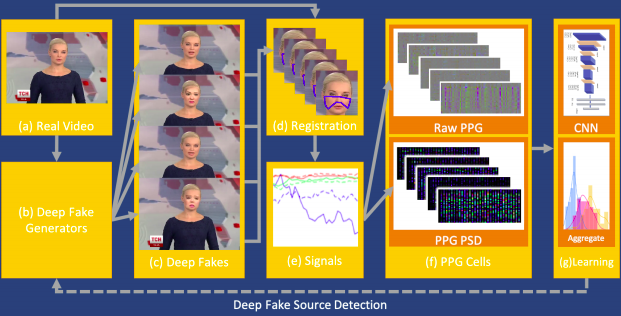

Des chercheurs ont récemment publié un rapport d’étude selon lequel les effets subtils de la circulation sanguine peuvent être utilisés pour détecter les deepfakes. Dans un article publié en juillet dernier dans la revue “IEEE Explore” titré “FakeCatcher : Detection of Synthetic Portrait Videos using Biological Signals”, les auteurs décrivent un logiciel qu'ils ont mis au point et qui tire parti du fait que les vidéos réelles de personnes contiennent des signaux physiologiques qui ne sont pas visibles à l'œil nu. Ces signaux sont aussi observables dans les deepfakes, mais ne sont pas fidèles à la réalité.

Les deepfakes sont de plus présents sur les plateformes Web, surtout les réseaux sociaux. Ces faux médias sont considérés par les organisations, y compris les gouvernements comme une menace directe pour la société, la loi et la vie privée. Même s’il existe des méthodes permettant de distinguer les deepfakes des vidéos, audios et images authentiques, les techniques de création de deepfakes ont beaucoup évolué au cours de ces dernières années et l’écart commence à se serrer entre les deepfakes et les méthodes de détection. Cette nouvelle approche pourrait être d’une grande importance.

Dans leur rapport, les chercheurs ont présenté une méthode de détection de deepfakes qui, selon eux, fait plus attention aux traits du corps que les anciennes approches qui utilisent aveuglément l’apprentissage profond. Ils considèrent que ces méthodes ne sont pas efficaces pour détecter les faux contenus, car les générateurs de deepfakes produisent des résultats très réalistes. Ainsi, le nouveau modèle qu’ils proposent se base sur la détection de signaux biologiques cachés dans les vidéos de portraits. Selon eux, l’IA ne peut pas imiter l’être humain dans tous les détails.

Ainsi, ils estiment que les signaux biologiques peuvent être utilisés comme un descripteur implicite de l'authenticité, car ils ne sont ni spatialement ni temporellement préservés dans le faux contenu. En particulier, la vidéo du visage d'un individu contient de subtils changements de couleur résultant des pulsations de la circulation sanguine. Vous pourriez imaginer que ces changements sont trop minimes pour être détectés simplement à partir d'une vidéo, mais le fait de regarder des vidéos améliorées pour exagérer ces changements de couleur vous fera rapidement oublier cette notion.

C’est sur ce phénomène que se base la technique appelée “photopléthysmographie”, ou PPG en abrégé, qui peut être utilisée, par exemple, pour surveiller les nouveau-nés sans avoir besoin d’attacher un objet à leur peau. Bien sûr, les deepfakes ne manquent pas de ces changements de couleur induits par la circulation, mais elles ne les recréent pas avec une grande fidélité. À partir de leur étude, les chercheurs ont constaté que “les signaux biologiques ne sont pas conservés de manière cohérente dans les différentes parties du visage synthétique”, mais ce n’est pas tout.

Ils ont également remarqué que le contenu synthétique ne contient pas de cadres avec un PPG stable. Plus précisément, les deepfakes ne peuvent pas imiter de manière convaincante la façon dont votre pouls se manifeste sur votre visage. Les anomalies des signaux PPG observées dans les deepfakes ont fourni aux chercheurs la base de leur propre système d'apprentissage profond, appelé FakeCatcher. Selon le rapport d’étude, celui-ci est capable de classer des vidéos avec le visage d'une personne comme étant réelles ou fausses, avec une précision supérieure à 90 %.

En plus, ils ont fait suivre cette étude d'une seconde montrant que leur approche peut être appliquée non seulement pour révéler qu'une vidéo est fausse, mais aussi pour montrer quel logiciel a été utilisé pour la créer. Ils ont publié la nouvelle étude le 26 août le serveur de préimpression arXiv. Ils y montrent qu'ils pouvaient distinguer avec une précision supérieure à 90 % si la vidéo était réelle, ou lequel des quatre générateurs de deepfakes (Deepfakes, Face2Face, FaceSwap ou NeuralTex) avait été utilisé pour créer une fausse vidéo.

Cette dernière étude est intitulée “How Do the Hearts of Deep Fakes Beat ? Deep Fake Source Detection via Interpreting Residuals with Biological Signals”. Les auteurs des deux études sont deux chercheurs de l’université de Binghamton (Umur Aybars Ciftci et Lijun Yin) et un autre d'Intel (Ilke Demir). Leur approche semble très efficace pour détecter les deepfakes et cela avec une grande précision. La question est de savoir si une nouvelle génération de générateurs de deepfakes sera un jour capable de déjouer cette approche de détection basée sur la physiologie. Au regard des progrès grandissant de l’IA, il ne fait aucun doute que cela finira par arriver, et peut-être très bientôt.

Sources : FakeCatcher, Rapport de la seconde étude

Et vous ?

Qu'en pensez-vous ?

Voir aussi

Les législateurs US estiment que la technologie deepfake constitue une menace à la sécurité nationale et appellent à des contremesures

Ne dites plus « deepfake » mais dites « vidéotox », préférez « divulgâcher » à « spoiler ». La Commission propose de nouvelles traductions officielles

Des deepfakes mettant en scène Vladimir Poutine et Kim Jong-un sont utilisés dans une campagne publicitaire politique, non pas pour perturber les élections, « mais protéger le droit de vote »

Répondre avec citation

Répondre avec citation

Partager