Sommes-nous préparés à la fin de la loi de Moore ?

Elle a alimenté la prospérité des 50 dernières années, mais la fin est maintenant en vue

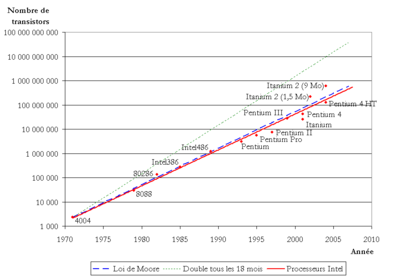

La loi de Moore est une loi empirique qui se rapporte à l'évolution de la puissance de calcul des ordinateurs et de la complexité du matériel informatique. Depuis son apparition, il y a un peu plus de soixante ans, l’évolution des circuits intégrés a suivi les prévisions de la loi. Cependant, plusieurs personnes dans l’industrie des semiconducteurs pensent que la loi est désormais arrivée à ses limites. D’un autre côté également, certains estiment que la fin de la loi pourrait ralentir le progrès technologique et nuire à des technologies comme l’intelligence artificielle.

En 1965, Gordon Moore prédisait que le nombre de composants d'un circuit intégré doublerait chaque année pour atteindre le chiffre étonnant de 65 000 en 1975, ce qui est vraiment arrivé. C’est la plus grande prévision technologique du dernier demi-siècle. Lorsqu'elle s'est révélée exacte en 1975, Moore a révisé la loi, en prévoyant un doublement des transistors sur une puce tous les deux ans. Depuis lors, sa prédiction a défini la trajectoire de la technologie et, à bien des égards, du progrès lui-même. L'argument de Moore était aussi d'ordre économique.

En 1965, Moore déclarait qu’avec les nouveaux circuits intégrés, le coût par composant est presque inversement proportionnel au nombre de composants. Moore a également vu qu'il y avait beaucoup de place pour des avancées techniques pour augmenter le nombre de transistors que vous pourriez mettre de manière abordable et fiable sur une puce. Ces puces moins chères et très puissantes sont ensuite devenues ce que les économistes appellent une technologie à usage général, une technologie si vitale qu'elle a engendré d'autres innovations dans de multiples secteurs.

Mais qu’arrivera-t-il lorsque la loi de Moore prendra fin ? Selon les analystes, l’industrie des semiconducteurs se retrouverait ralentir et par ricochet, les progrès technologiques. Comme certains le soupçonnent, la loi a déjà pris fin et nous sommes en train de fonctionner avec les vapeurs du plus grand moteur technologique de notre temps. D’après Charles Leiserson, informaticien au MIT et pionnier du calcul parallèle : « C'est fini. Cette année, c'est devenu vraiment clair ». Selon lui, ceci se traduit par le retard dans la livraison de nouvelles puces.

Selon l’analyse du MIT Technology Review, la toute dernière usine de fabrication d'Intel, destinée à fabriquer des puces dont la taille minimale des caractéristiques est de 10 nanomètres, a pris énormément de retard. Elle a livré des puces en 2019, cinq ans après la génération précédente de puces de 14 nanomètres. La loi de Moore, selon Leiserson, a toujours porté sur le rythme du progrès, et « nous ne sommes plus à ce rythme ». De nombreux autres informaticiens éminents ont aussi déclaré ces dernières années que la loi de Moore était morte.

Début 2019, le PDG du grand fabricant de puces Nvidia a donné son accord. « La loi de Moore avait l'habitude de croître à x10 tous les cinq ans et x100 tous les 10 ans », a expliqué Jensen Huang, PDG de Nvidia. « En ce moment, la loi de Moore augmente de quelques pour cent chaque année. Peut-être x2 seulement tous les 10 ans. La loi de Moore est donc terminée », a-t-il conclu. En vérité, il s'agit plus d'un déclin progressif que d'une mort subite. Au fil des décennies, certains, dont Moore lui-même parfois, se sont inquiétés de voir la fin en vue.

Il devenait de plus en plus difficile de fabriquer des transistors de plus en plus petits. Pendant des années, l'industrie des puces a réussi à contourner ces obstacles physiques. Mais le progrès est devenu de plus en plus coûteux. Les économistes de Stanford et du MIT ont calculé que l'effort de recherche visant à faire respecter la loi de Moore a été multiplié par 18 depuis 1971. De plus, les laboratoires qui fabriquent les puces les plus avancées deviennent hors de prix. Le coût d'une usine augmente d'au moins 13 % par an et attendra 16 milliards de dollars ou plus d'ici 2022.

Selon le rapport du MIT Technology Review, c’est la raison pour laquelle le nombre d’entreprises qui prévoient de fabriquer la prochaine génération de puces est en constante baisse depuis 2002, ils ne seraient désormais plus que trois. Néanmoins, des enseignes comme Intel, l'un de ces trois fabricants de puces, ne voient pas la fin de la loi de Moore pour tout de suite. Jim Keller, qui dirige l'ingénierie de silicium d'Intel trouve qu’il existe encore de nombreuses possibilités de progrès. Il estime que chacune de ces possibilités est toutefois un couteau à double tranchant.

Selon lui, il y a probablement plus d'une centaine de variables qui interviennent dans le maintien de la loi de Moore, chacune d'entre elles apportant des avantages différents et se heurtant à ses propres limites. Cela signifie qu'il existe de nombreuses façons de continuer à doubler le nombre de dispositifs sur un processeur, des innovations telles que les architectures 3D et les nouveaux designs de transistors. Il est optimiste sur la question et affirme qu'Intel est sur la bonne voie pour les dix prochaines années.

Cependant, même si Intel et les autres fabricants de puces peuvent produire quelques générations supplémentaires de puces encore plus avancées, l'époque où l'on pouvait compter sur des puces plus rapides et moins chères tous les deux ans est révolue. Mais cela ne signifie pas pour autant la fin des progrès informatiques. Dans un rapport, Leiserson et Neil Thompson, économiste au CSAIL du MIT ont expliqué que l’industrie a des possibilités pour améliorer les performances de calcul grâce à de meilleurs logiciels, des algorithmes et une architecture de puce spécialisée.

L'une d’entre elles consiste à réduire le ballonnement des logiciels pour tirer le meilleur parti des puces existantes. Lorsque l'on pouvait encore compter sur les puces pour devenir plus rapides et plus puissantes, les programmeurs ne se souciaient pas beaucoup d'écrire du code plus efficace. Et souvent, ils ne parvenaient pas à tirer pleinement parti des changements dans l'architecture matérielle, comme les multiples cœurs ou processeurs que l'on trouve dans les puces utilisées aujourd'hui.

Et vous ?

Quel est votre avis sur le sujet ?

Voir aussi

La fin de la loi de Moore arrêtera-t-elle les progrès de l'intelligence artificielle ? Les avis sur la question sont plutôt mitigés

Un ingénieur de Google estime qu'il est temps de créer de nouveaux langages et architectures informatiques, la loi de Moore ayant atteint ses limites

Google aurait mené la première véritable expérience qui établit la suprématie quantique avec un système qui résout en 3 min un calcul dont la résolution prendrait 10 000 ans sur un supercalculateur

IBM conçoit un processeur de 50 qubits et évoque la suprématie quantique. Comment se traduit ce nombre de qubits dans la réalité ?

Répondre avec citation

Répondre avec citation

Le site doit s'adapter à trop d'écrans c'est l'horreur. (on ne peut pas se dire "ça s'affiche sur un écran 800*600 et sur un écran de 1024*768, donc on est bon")

Le site doit s'adapter à trop d'écrans c'est l'horreur. (on ne peut pas se dire "ça s'affiche sur un écran 800*600 et sur un écran de 1024*768, donc on est bon")

Partager