Bonjour,

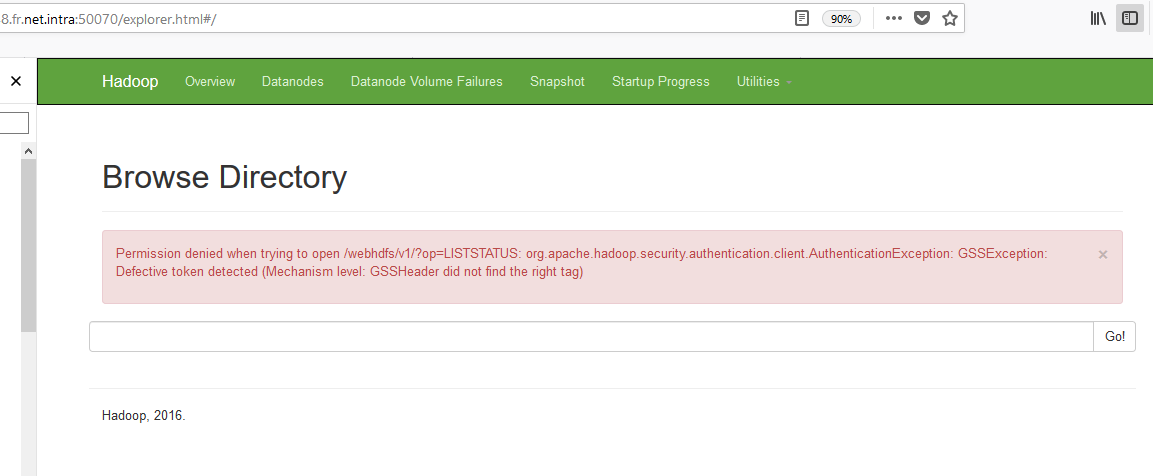

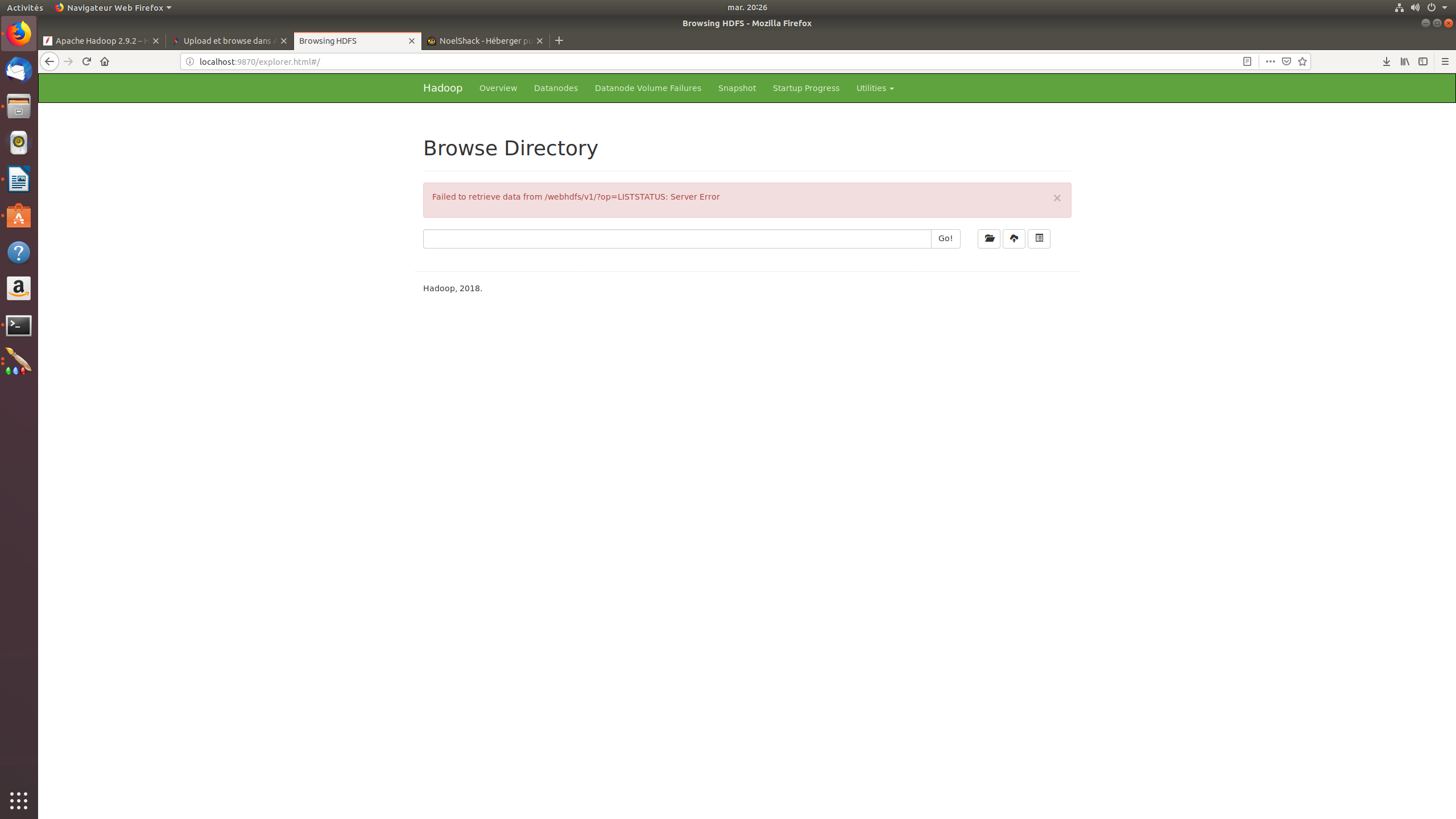

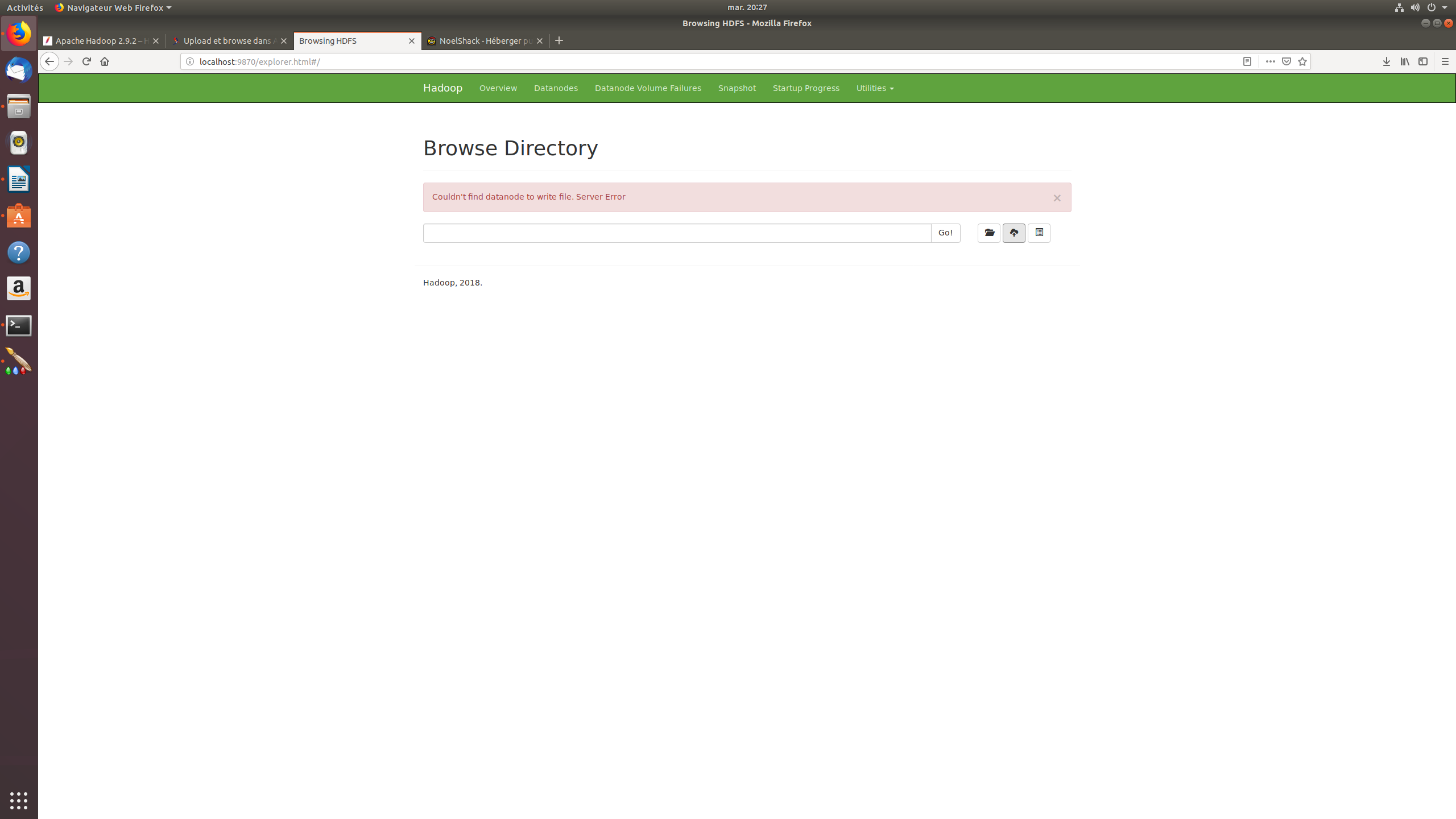

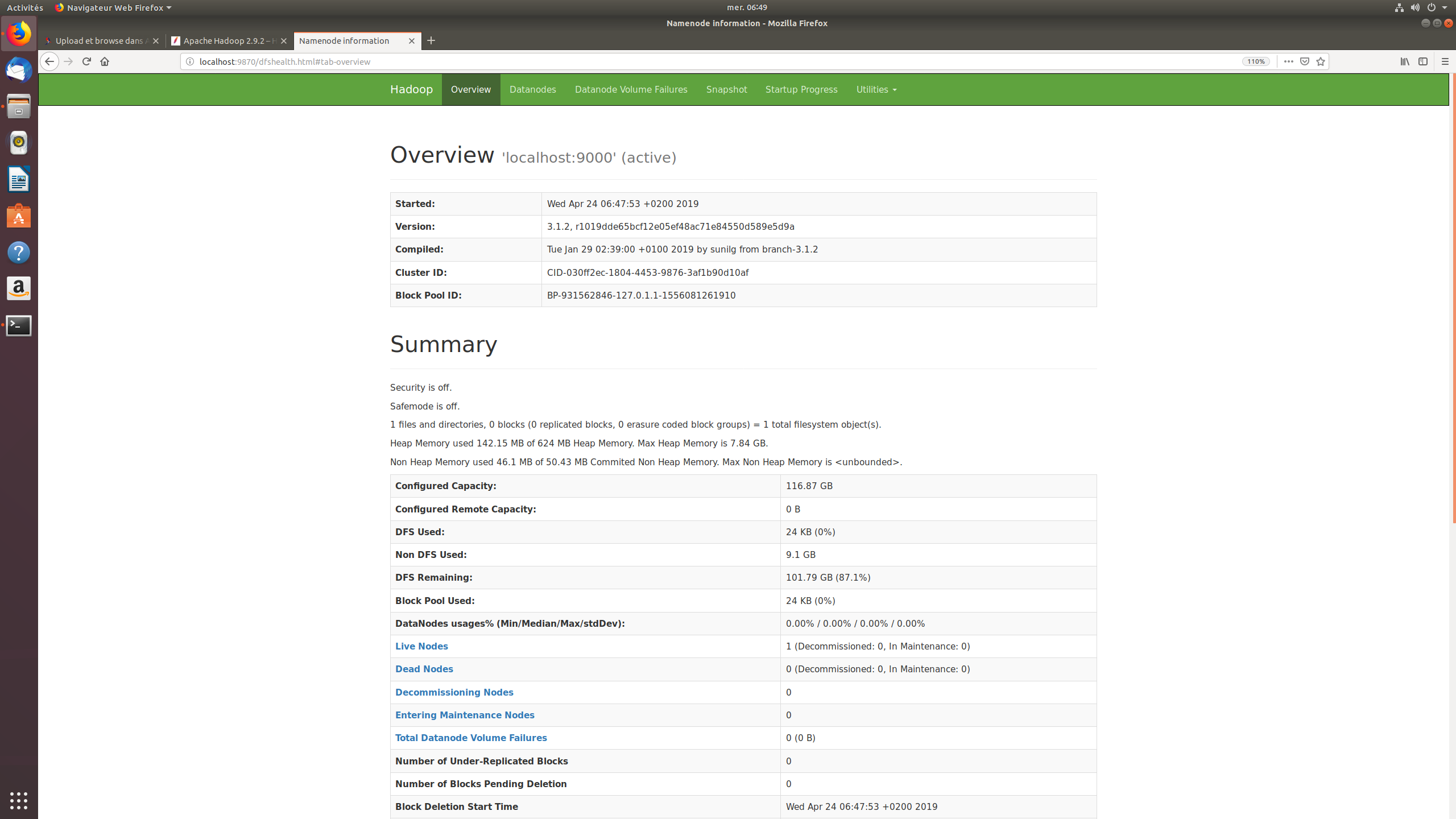

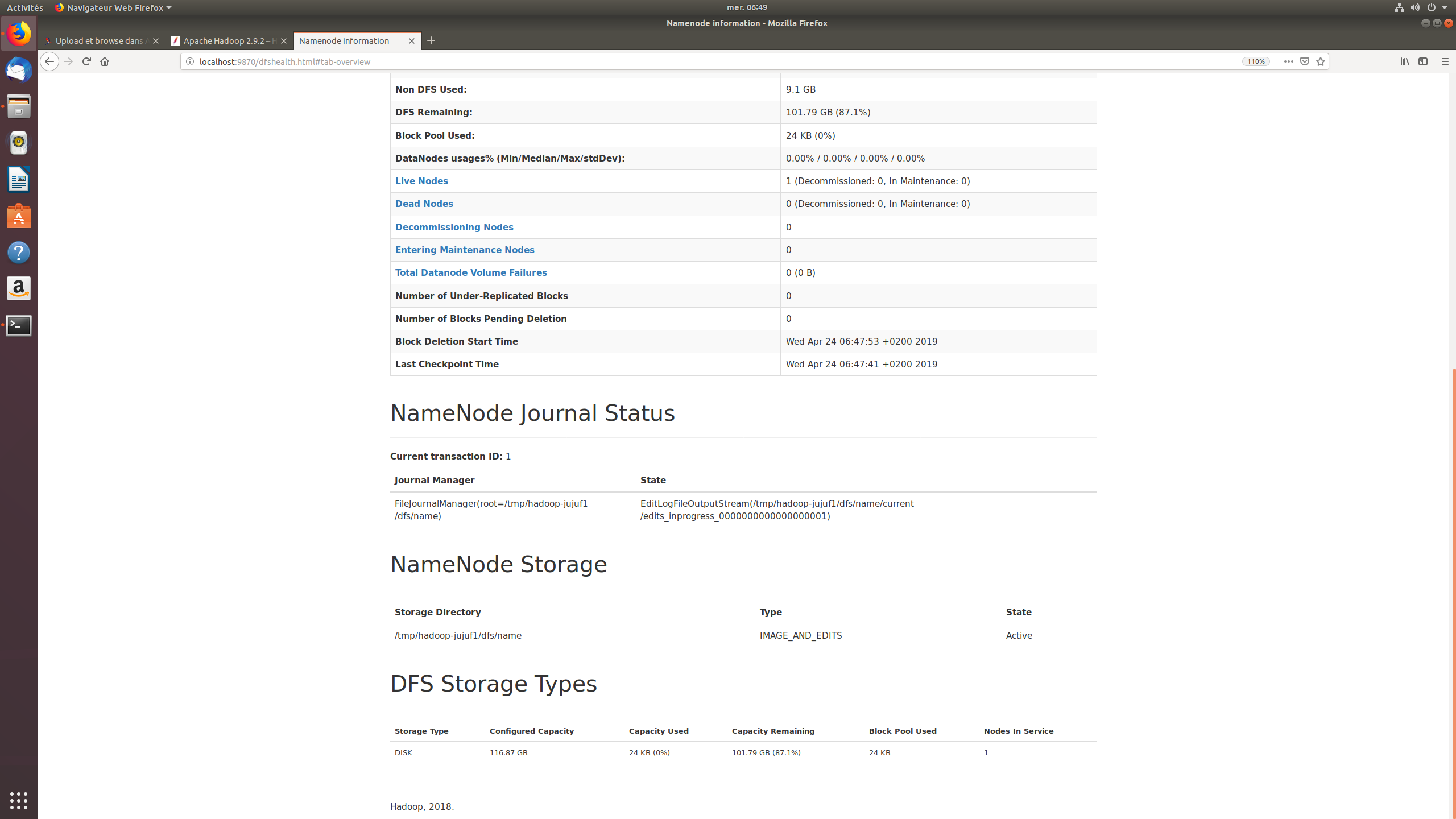

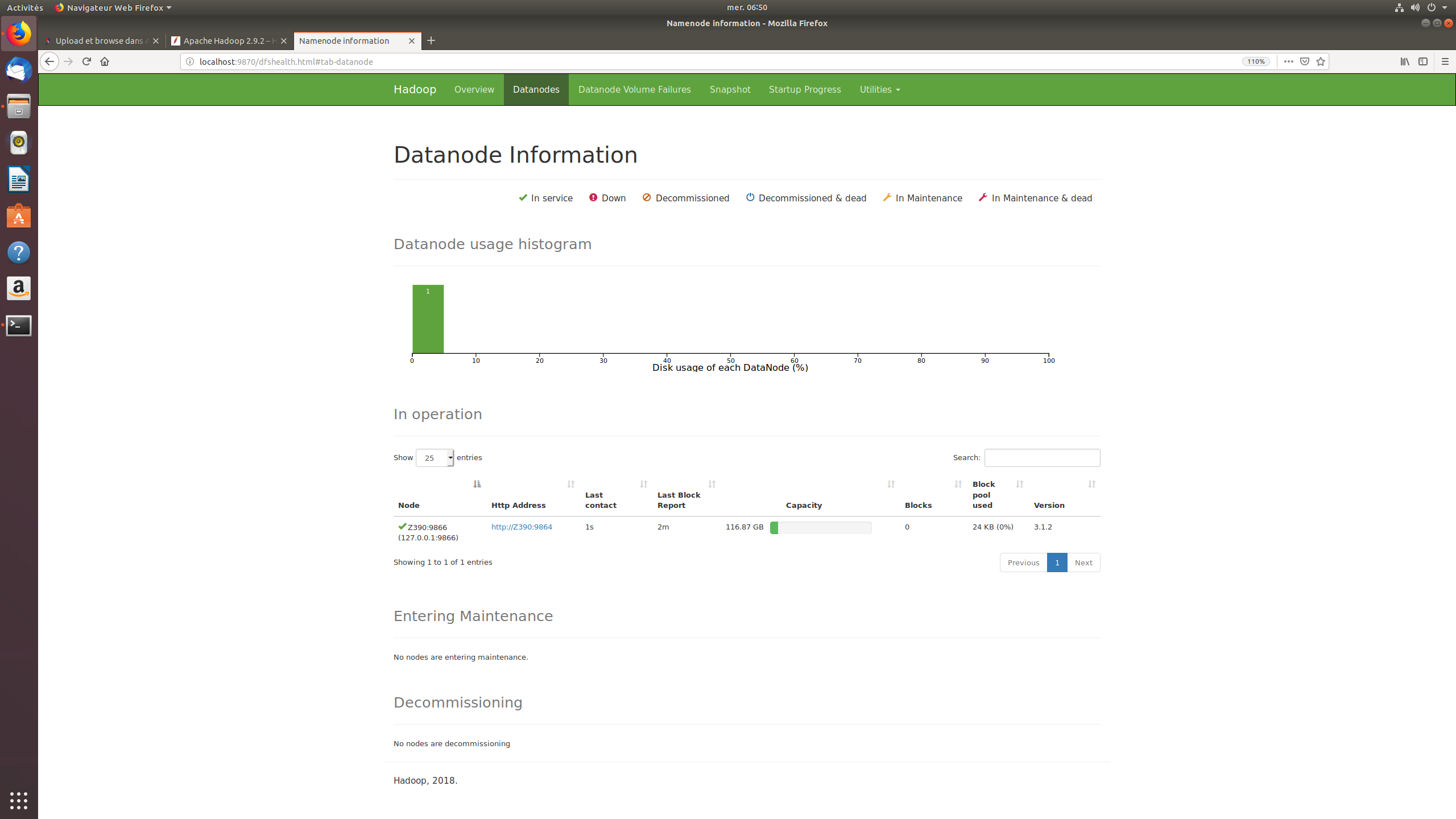

J'essaie de faire tourner Apache Hadoop sur Ubuntu (pas en virtuel) avec un seul nœud. Lorsque je clique sur browse et upload file, il me sort une erreur lié au webhfs ou un truc du genre (désolé je n'ai pas l'erreur sous la main car je suis retourné sur Windows). J'ajoute que j'ai installé Hadoop apache plusieurs fois avec des tutos différents sans résultat (toujours la même erreur…).

Est-ce normal ? ou qu'ai-je mal fait ?

Merci d'avance.

Répondre avec citation

Répondre avec citation

Partager