L'IA peut être exploitée pour favoriser un discours empathique et lutter contre le harcèlement en ligne, ouvrant la voie à un paysage numérique plus doux, d'après des chercheurs de la BYU et de Duke

Des chercheurs de la Brigham Young University (BYU) et de Duke exploitent l'IA pour favoriser un discours empathique et lutter contre le harcèlement en ligne, ouvrant ainsi la voie à un paysage numérique plus doux.

En consultant la section des commentaires de nombreux médias sociaux et plateformes d'information numériques, vous risquez de trouver un réservoir d'insultes, de menaces et même de harcèlement. En fait, une enquête du Pew Research Center a révélé que 41 % des adultes américains ont été personnellement victimes de harcèlement en ligne, et un adulte sur cinq dit avoir été harcelé en ligne en raison de ses opinions politiques.

Toutefois, des chercheurs de l'université BYU et de l'université Duke affirment que les conversations dérisoires en ligne ne doivent pas être la norme. Un article publié conjointement par les deux universités montre que l'intelligence artificielle peut être utilisée pour améliorer la qualité des conversations et promouvoir un dialogue civil dans les interactions en ligne.

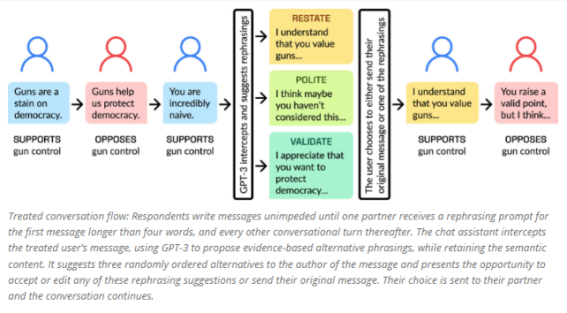

À l'aide d'une plateforme en ligne spécialement conçue par Vin Howe, étudiant de la BYU, les chercheurs ont mené une expérience originale. Ils ont jumelé des participants aux points de vue opposés dans un chat en ligne et leur ont demandé de discuter d'un sujet très polarisé dans la politique américaine : le contrôle des armes à feu. Au cours de la conversation, l'un des utilisateurs recevait par intermittence un prompt d'un outil d'intelligence artificielle lui suggérant de reformuler son message pour le rendre plus poli ou plus amical, mais sans en modifier le contenu. Les participants étaient libres d'adopter, de modifier ou de rejeter la suggestion de l'outil d'IA. À la fin du chat, les participants ont été dirigés vers un questionnaire pour évaluer la qualité de la conversation.

Plus de 1 500 personnes ont participé à l'expérience. Au total, 2 742 reformulations générées par l'IA ont été acceptées par les participants. Les résultats ont révélé une transformation prometteuse de la dynamique des interactions en ligne. Les partenaires de discussion des personnes qui ont mis en œuvre une ou plusieurs suggestions de reformulation de l'IA ont fait état d'une qualité de conversation nettement supérieure et, fait remarquable, se sont montrés plus disposés à écouter les points de vue de leurs adversaires politiques.

"Nous avons constaté que plus les reformulations étaient utilisées, plus les participants avaient l'impression que la conversation n'était pas conflictuelle et qu'ils se sentaient entendus et compris", a déclaré David Wingate, professeur d'informatique à la BYU et coauteur de l'étude, qui participe au lancement du diplôme d'informatique de la BYU avec une spécialisation dans l'apprentissage automatique.

Il est important de noter que les reformulations assistées par l'IA n'ont pas modifié le contenu des conversations, ni les points de vue des participants, a déclaré M. Wingate, qui a fait remarquer que l'assistance au chat par l'IA est très différente de l'IA persuasive, qui est dangereuse et problématique sur le plan éthique. "Mais aider les gens à avoir des conversations productives et courtoises est l'un des résultats positifs de l'IA."

Les implications de cette recherche sont considérables, car elle offre une solution évolutive pour lutter contre la culture en ligne toxique qui sévit sur l'internet depuis des années. Contrairement aux méthodes traditionnelles, telles que les sessions de formation professionnelle dirigées par des modérateurs experts, dont la portée et la disponibilité sont limitées, l'intervention de l'IA peut être mise en œuvre à grande échelle sur différents canaux numériques.

Howe affirme que le fait d'avoir eu l'occasion de coécrire l'étude en tant qu'étudiant de premier cycle est un point fort de son expérience à BYU et il est reconnaissant à Wingate et à ses collègues professeurs de BYU, Lisa Argyle, Ethan Busby et Josh Gubler, qui l'ont encadré. Son travail sur ce projet a fait naître en lui le désir de continuer à chercher comment la technologie peut avoir un impact positif sur la société.

"La recherche encadrée a été la meilleure partie de mon expérience à BYU", déclare Howe. "J'ai rencontré tant de personnes intéressantes et engagées grâce aux possibilités de recherche encadrée que j'ai eues. Je ne sais pas si j'aurais vécu une telle expérience ailleurs".

En utilisant correctement le pouvoir de l'IA, les plateformes en ligne pourraient être transformées en forums constructifs où des individus d'horizons et d'opinions différents se réunissent pour discuter de questions d'actualité avec empathie et respect. En fin de compte, cette étude montre que la technologie de l'IA, lorsqu'elle est intégrée de manière réfléchie, peut jouer un rôle essentiel dans la création d'un paysage en ligne plus positif.

"J'espère que de plus en plus d'étudiants de la BYU créeront des applications prosociales comme celle-ci et que la BYU deviendra un chef de file dans la démonstration de méthodes éthiques d'utilisation de l'apprentissage automatique", a déclaré M. Wingate. "Dans un monde dominé par l'information, nous avons besoin d'étudiants capables de manipuler l'information mondiale de manière positive et socialement productive."

L'étude a été récemment publiée dans la revue scientifique PNAS par Wingate et les professeurs de la BYU Lisa Argyle, Ethan Busby et Josh Gubler, ainsi que le professeur Chris Bail de l'université Duke. Chris Rytting et Taylor Sorensen, anciens étudiants diplômés de la BYU, sont également coauteurs de l'étude.

Source : Leveraging AI for democratic discourse: Chat interventions can improve online political conversations at scale

Et vous ?

Quel est votre avis sur le sujet ?

Que pensez-vous de cette initiative des chercheurs de la BYU et de DUKE ? Trouvez-vous que cette application de l'IA est pertinente et cohérente ?

Voir aussi

Call Of Duty utilise l'intelligence artificielle pour détecter les propos haineux lors des matchs en ligne et améliorer la modération

Jigsaw, le projet de Google pour préserver les sociétés ouvertes, utilisait l'IA contre les discours toxiques, mais l'IA a fini par déraper

Les textes générés par l'IA pourraient accroître l'exposition aux menaces, l'identification des contenus malveillants ou abusifs deviendra plus difficile pour les fournisseurs de plateformes

Répondre avec citation

Répondre avec citation

Partager