Les experts de l'Union européenne publient le premier draft sur les lignes directrices d'une IA éthique,

la version finale est attendue en mars 2019

Mi-juin 2018, la Commission européenne a nommé 52 experts au sein du nouveau groupe de haut niveau sur l'intelligence artificielle (le High Level Expert Group on Artificial Intelligence). Le groupe, composé de représentants du monde universitaire, des entreprises et de la société civile, avait pour vocation de soutenir la mise en œuvre de la communication de l'UE sur l'intelligence artificielle publiée en avril 2018.

C’est donc dans le cadre de ses fonctions, mais également des délais imposés par Bruxelles, que le AI HLEG (High Level Group on Artificial Intelligence) a publié le premier draft sur les lignes directrices sur l'éthique pour une IA de confiance.Envoyé par Bruxelles

Définitions

Avant d’aller dans le vif du sujet, ils ont commencé par donner quelques définitions, notamment :

Intelligence artificielle ou IA:

L’intelligence artificielle (IA) fait référence à des systèmes conçus par des humains qui, face à un objectif complexe, agissent dans le monde physique ou numérique en percevant leur environnement, en interprétant les données collectées, données structurées ou non structurées, raisonnant sur les connaissances tirées de ces données et décidant de la (des) meilleure (s) mesure (s) à prendre (selon des paramètres prédéfinis) pour atteindre l’objectif. Les systèmes d'intelligence artificielle peuvent également être conçus pour apprendre à adapter leur comportement en analysant la manière dont l'environnement est affecté par leurs actions précédentes.

En tant que discipline scientifique, l'intelligence artificielle comprend plusieurs approches et techniques, telles que l'apprentissage automatique (dont l'apprentissage en profondeur et l'apprentissage par renforcement sont des exemples spécifiques), le raisonnement automatique (planification, ordonnancement, représentation et raisonnement des connaissances, recherche et optimisation), et la robotique (qui comprend le contrôle, la perception, les capteurs et les actionneurs, ainsi que l'intégration de toutes les autres techniques dans des systèmes cyberphysiques).

Partialité (bias):

Une partialité est un préjudice pour ou contre quelque chose ou quelqu'un qui peut entraîner des décisions injustes. On sait que les humains sont biaisés dans leur prise de décision. Comme les systèmes d'IA sont conçus par des humains, il est possible que les humains leur injectent leurs préjugés, même de manière non intentionnelle. De nombreux systèmes d'IA actuels reposent sur des techniques d'apprentissage automatique. Par conséquent, un moyen prédominant d’injecter de la partialité peut être la collecte et la sélection de données d’entraînement. Si les données de formation ne sont pas assez complètes et équilibrées, le système pourrait apprendre à prendre des décisions injustes. En même temps, l'IA peut aider les humains à identifier leurs partialités et les aider à prendre des décisions moins biaisées.

But éthique:

Dans ce document, le but éthique est utilisé pour indiquer le développement, le déploiement et l'utilisation de l'intelligence artificielle garantissant le respect des droits fondamentaux et de la réglementation applicable, ainsi que le respect des principes et valeurs fondamentaux. C’est l’un des deux éléments essentiels pour parvenir à une IA digne de confiance.

IA centrée sur l'homme:

L’approche centrée sur l’être humain vis-à-vis de l’IA s’efforce de faire en sorte que les valeurs humaines soient toujours au premier rang des préoccupations et nous oblige à garder à l’esprit que le développement et l’utilisation de l’IA ne doivent pas être considérés comme un moyen en soi, mais dans le but bien-être.

IA digne de confiance:

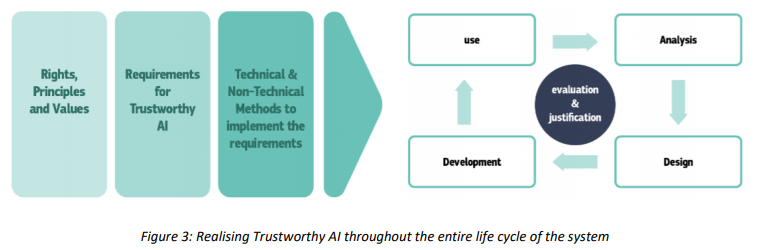

Une IA digne de confiance comporte deux éléments: (1) son développement, son déploiement et son utilisation doivent respecter les droits fondamentaux et la réglementation applicable, ainsi que les principes et valeurs fondamentaux garantissant un «objectif éthique», et (2) être robustes et fiables sur le plan technique.

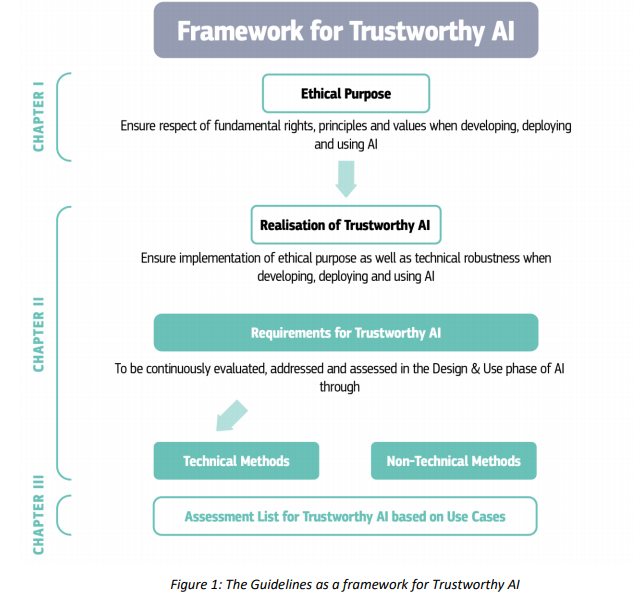

Constitution du draft

Chaque chapitre des directives fournit des conseils sur la réalisation d'une IA digne de confiance, adressés à toutes les parties prenantes concernées développant, déployant ou utilisant une IA, résumé ci-dessous:

Chapitre I: Principales lignes directrices pour garantir un objectif éthique

- Veiller à ce que l'IA soit centrée sur l'humain : l'IA devrait être développée, déployée et utilisée dans un « but éthique », fondé sur les droits fondamentaux, les valeurs sociales et les principes éthiques de bienfaisance (faire le bien), de non-malfaisance (ne pas nuire), autonomie des humains, justice et explicabilité. Ceci est crucial pour aller vers une IA digne de confiance.

- S'appuyer sur les droits fondamentaux , les principes éthiques et les valeurs pour évaluer de manière prospective les effets possibles de l'IA sur l'homme et le bien commun. Porter une attention particulière aux situations impliquant des groupes plus vulnérables tels que les enfants, les personnes handicapées ou des minorités, ou aux situations d'asymétrie de pouvoir ou d'information, telles qu'entre employeurs et employés, ou entre entreprises et consommateurs.

- Reconnaître et être conscient du fait que, tout en apportant des avantages substantiels aux individus et à la société, l'IA peut également avoir un impact négatif. Rester vigilant pour les domaines critiques.

Chapitre II: Conseils clés pour réaliser une IA digne de confiance

- Intégrer les exigences relatives à l'IA de confiance dès la première phase de conception: responsabilité, gouvernance des données, conception pour tous, gouvernance de l'autonomie de l'IA (surveillance humaine), non-discrimination, respect de l'autonomie humaine, respect de la vie privée, robustesse, sécurité, transparence.

- Envisager des méthodes techniques et non techniques pour assurer la mise en œuvre de ces exigences dans le système d'IA. De plus, tenir compte de ces exigences lors de la constitution d’une équipe chargée de travailler sur le système, le système lui-même, l’environnement de test et les applications potentielles du système.

La réaction de Bruxelles à ce premier draft

Le vice-président de la Commission pour le marché unique numérique, Andrus Ansip, et la commissaire en charge de l'économie et de la société numériques, Mariya Gabriel, ont remercié le groupe pour leur travail.

Andrus Ansip, vice-président de la Commission pour le marché unique numérique, a déclaré :

La commissaire à l'économie et à la société numériques, Mariya Gabriel, a ajouté:Envoyé par Andrus Ansip

Le draft sur les principes directeurs en matière d’éthique sur l’IA est maintenant ouvert aux débats jusqu’au 18 janvier et des discussions sont en cours au sein de l’Alliance européenne sur l’IA, la plateforme multipartite de l’UE sur l’intelligence artificielle.Envoyé par Mariya Gabriel

En mars 2019, le groupe d'experts va présenter la version finale de ces lignes directrices à la Commission, qui les analysera et lui proposera des moyens de faire progresser ces travaux. L'ambition est alors de faire passer l'approche éthique de l'Europe sur la scène mondiale. La Commission assure qu’elle ouvre actuellement sa coopération à tous les pays non membres de l'UE souhaitant partager les mêmes valeurs.

Sources : draft (au format PDF), réaction de Bruxelles, annonce de la constitution de l'équipe AI HLEG

Et vous ?

Qu'en pensez-vous ?

Voir aussi :

Quelles sont les avantages et les inconvénients de l'Intelligence artificielle ? Noodle.ai, spécialiste de l'IA, donne son point de vue

UE : les États membres vont collaborer pour stimuler l'intelligence artificielle « fabriquée en Europe », pour combler le retard pris sur les USA

La France dévoile son plan sur l'Intelligence artificielle pour 665 millions d'euros, quelles en sont les grandes lignes ?

L'ICLR, une importante conférence sur l'intelligence artificielle se tiendra en Afrique en 2020 à cause de problèmes de visas

Chef de l'ONU : « La militarisation de l'intelligence artificielle est un grave danger », Guterres met en garde contre l'impact de la technologie

Répondre avec citation

Répondre avec citation

Partager