Je viens de regarder la doc de ta caméra 1.

Ne prend pas mal cette question, c'est juste pour moi savoir si tu as exploré plusieurs solutions.

*******************

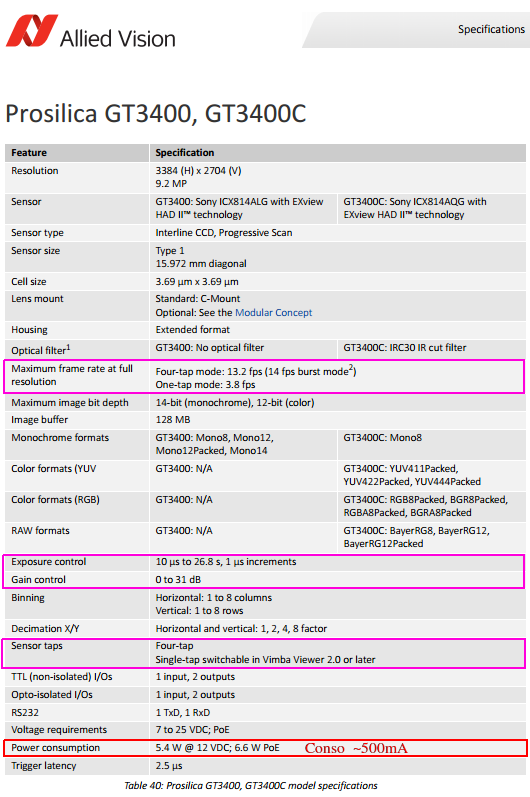

Cette caméra a un temps d'exposition réglable de 10µs à 26.8s, le temps d'exposition d'un capteur CCD correspond à la durée d'accumulation de lumière. C'est a dire que plus tu augmentes le temps d'exposition, plus tu laisses le capteur se charger en lumière et donc plus tu as de détails. En astrophotographie c'est une pratique courante, on place un appareil photo numérique sur l'objectif d'un télescope, on attend simplement que le capteur se charge avec le peu de lumière que le télescope nous donne puis on prend une photo et on recommence en ayant pris soin de modifier la position du télescope car la terre bouge. Plus on attend longtemps et plus on voit de détails, c'est comme ça que nous nous sommes aperçu que même les zones du ciel qui nous paraissent noirs, abritent en réalité un nombre impressionnant d'astre en tout genre.

Au lieu de demander à la caméra de courir avec un débit de dingue, as tu essayer de lui demander de la qualité en augmentant le temps d'exposition au détriment du nombre d'images par seconde ?

Répondre avec citation

Répondre avec citation

)

)

Partager