Bonjour à tous,

En ce moment j'essaie de connaitre la taille des types comme int, double, ... avec un processeur 16, 32 (ou 64 bits).

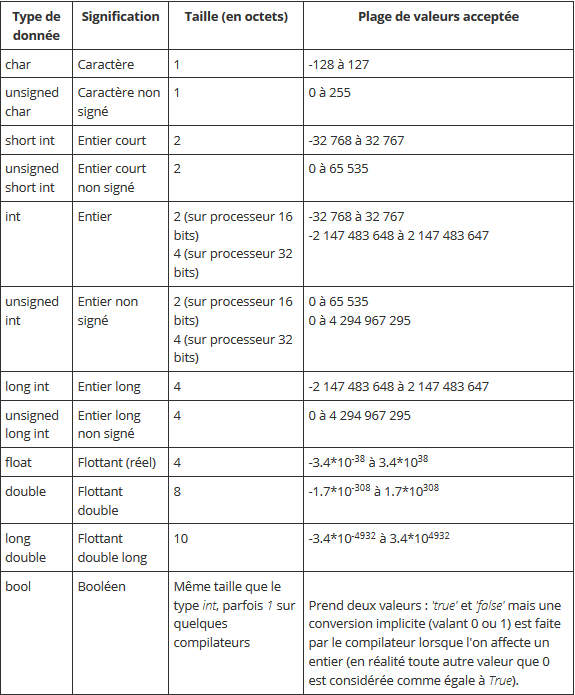

Est-ce que le tableau suivant est correcte (ce tableau est valable sur le site comment ça marche pour le C++) ? Je remarque que seulement les entiers changent avec 16 ou 32 bits mais les doubles et les floats restent à la meme taille, ...

Je ne sais pas sur quel base partir pour calculer la taille des types en C.

----------

Également, j'aimerais parler du cast. Sur les lignes de code ci-dessous, pourquoi on a (char*) et pas (char).

Voila, merci à vous

Code : Sélectionner tout - Visualiser dans une fenêtre à part

2

3

4

5

6

7

8

Répondre avec citation

Répondre avec citation

Partager