Bonjour,

Je mets sciemment ce topic dans "Performance web" car je pense qu'il s'agit d'un problème de lenteur de mon hébergeur...

J'utilise google webmaster pour analyser le comportement de google sur mon site internet.

J'ai créé un fichier robots.txt, que j'ai placé à la racine de mon site et j'ai mis les droits en 755 dessus. J'ai bien vérifié, ce fichier ne présente pas d'erreur.

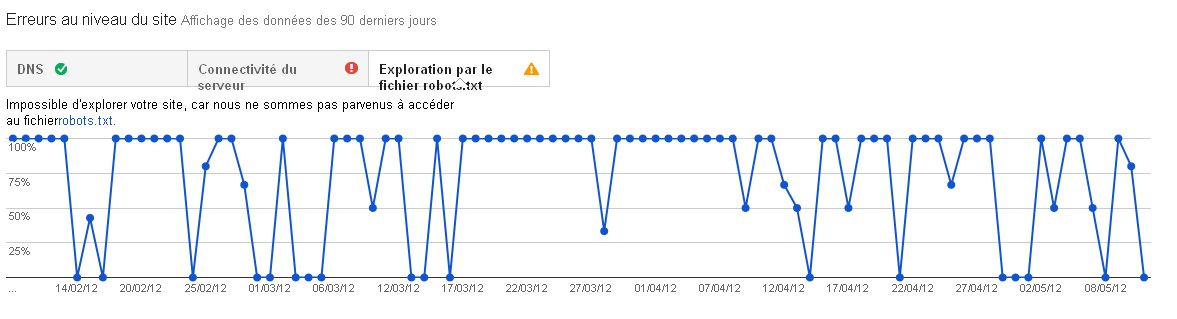

Google n'arrive à accéder à ce fichier que par intermittence et m'indique qu'ils préfèrent attendre avant de le traiter. Voici le screenshot :

L'outil de google signale que mon site rencontre parfois des problèmes de connectivité, mais c'est sans commune mesure avec les problèmes d'accès à robots.txt, qui est pourtant de très faible taille et que j'accède systématiquement quand je clique sur le lien de google developper...

Ce qui m'étonne, c'est que j'ai créé un fichier sitemaps et que je n'ai aucun problème avec, il est bien reconnu.

Cela fait plusieurs mois que j'ai ce problème. En consultant les forums, j'ai pu voir que cela prenait du temps, mais là je désespère...

J'ai trouvé un post sur un blog parlant d'un problème analogue. Il parait que certains hébergeurs bloquent des bots de google, par "sécurité". Mon hébergeur est orange business. Pour résoudre le problème, ils ont mis dans leur fichier .htaccess :

C'est ce que j'ai fait. J'ai patienté un mois, mais le problème reste le même...

Code : Sélectionner tout - Visualiser dans une fenêtre à part

2

3

Quelqu'un aurait une idée ? (à part effacer ce maudit fichier ?)

Merci d'avance.

Répondre avec citation

Répondre avec citation

Partager