On peut toujours faire de l'approximation.

Cette technique est déjà utilisé dans le moteur Frosbite à partir de la version 2 (Battlefield 3 et +)

Cela fonctionnement bien pour certain type de lumière, mais c'est quand même "super limité".

La démo de Brigade 3 c'est 2 cartes NVIDIA à 1000€ la carte et c'est déjà hyper optimisé.

Et même si niveau code on améliore encore les performances, même si on fait 30% mieux (ce qui serait déjà énorme), et même en optimisant encore on arrive à faire 2 fois plus rapide niveau soft, il n'y a pas de miracle, cela va être 2 fois moins bruité et c'est "tout". Pour avoir un rendu complet cela nécessite forcément du hardware 100 à 1000x plus puissant. Le facteur d'échelle n'est pas le même.

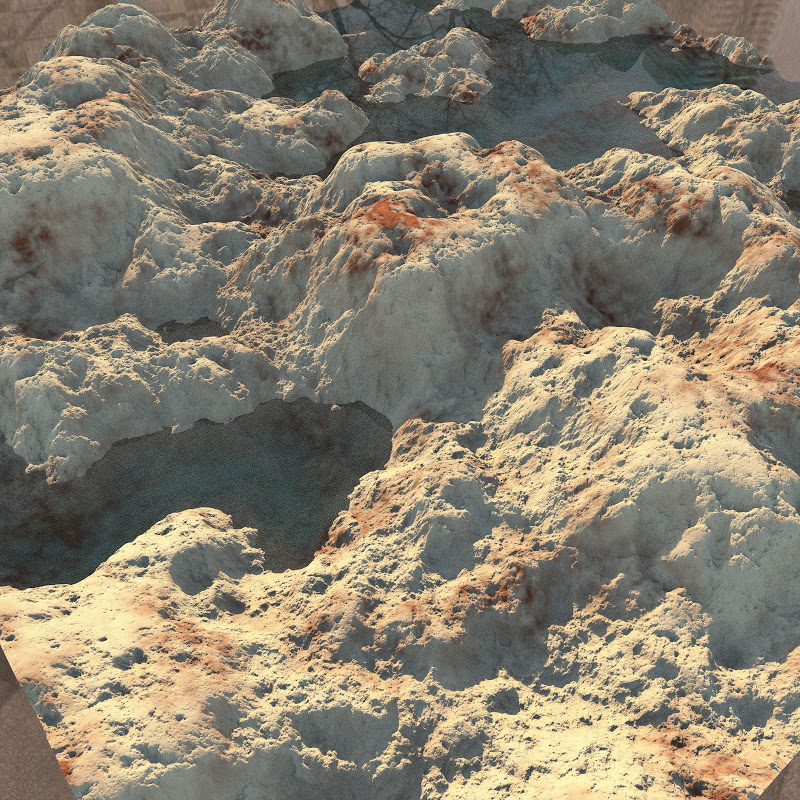

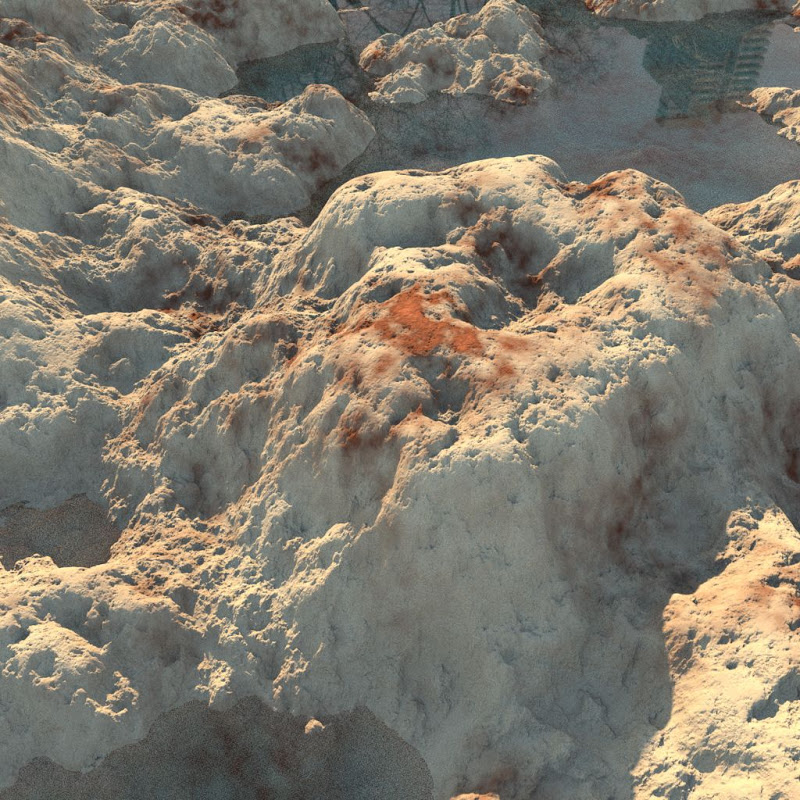

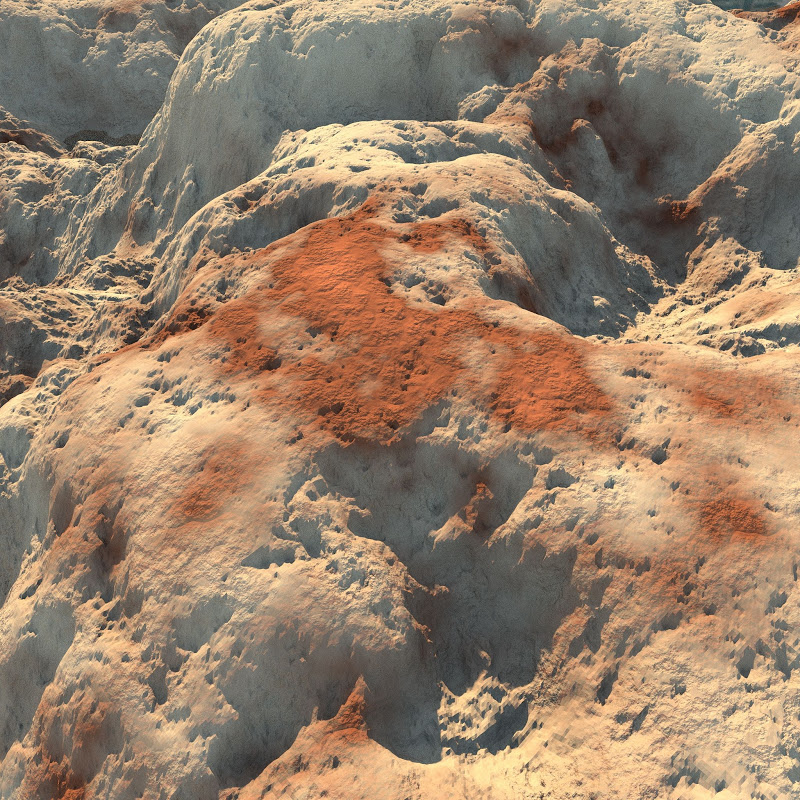

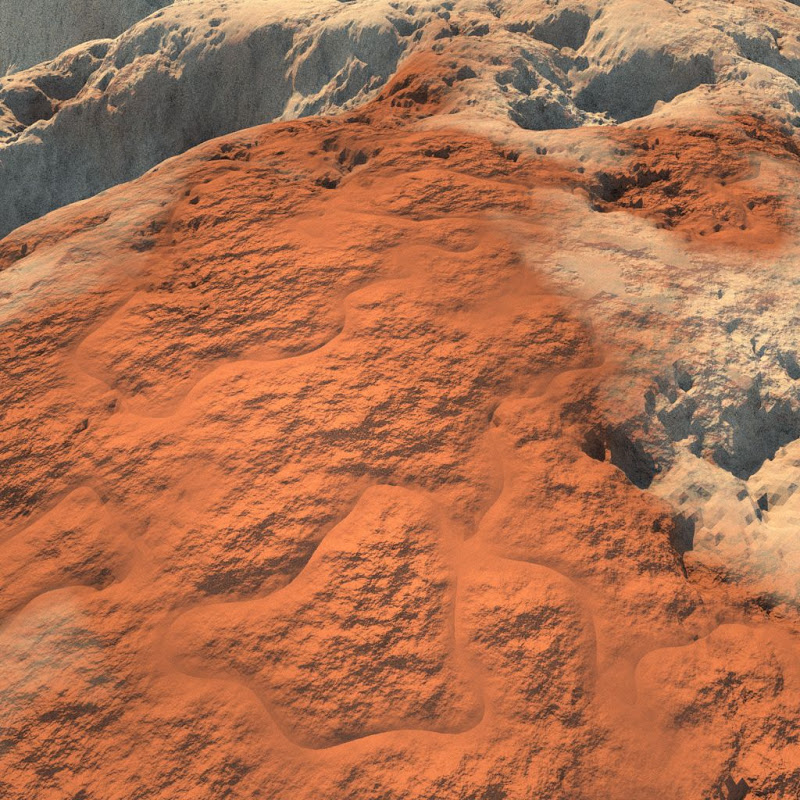

Et d'ailleurs cela ne sert à rien d'avoir un moteur de folie sans avoir toutes les données pour nourrir le moteur. Donc faire des textures super détaillés, des meshs super détaillés (même si on fait de la tesselation dynamique, il faut quand même des tonnes de données super haute résolution au départ pour générer les textures). Et faut animer tout cela, donner de l’intelligence artificiel qui va aussi loin etc...

Le moteur 3D c'est presque juste un "détail" pour avoir un jeu complet.

Mirror Edge c'est énormément de pré-calculé et super bien fait.

Wolfenstein 3D c'est du raycasting, je n'ai rien contre la technique mais c'est vraiment une niche du raytracing et on ne peut pas vraiment mettre les 2 sur le même plan (comprendre le jeu de mot).

Répondre avec citation

Répondre avec citation

Partager